生成AIの実務導入において最大の壁となる「ハルシネーション(もっともらしい嘘)」。AWSのAutomated Reasoning Group(自動推論グループ)の取り組みを題材に、確率的なLLMを論理的に制御するアプローチと、日本企業が採用すべきガバナンスのあり方を解説します。

なぜ「確率」だけでは企業ユースに耐えられないのか

生成AI、特に大規模言語モデル(LLM)の導入を検討する企業の多くが直面する課題が「ハルシネーション(幻覚)」です。元記事でも触れられている通り、AIが自信満々に架空の給与データを出力してしまうような事態は、企業のコンプライアンス上、決して許容できるものではありません。

LLMは本質的に「確率論的(Probabilistic)」な仕組みで動いています。次に続く単語を統計的に予測しているに過ぎず、そこに「真実かどうか」という判断基準は含まれていません。日本ではRAG(検索拡張生成)による回答精度の向上が一般的ですが、RAGであっても参照データをLLMが誤読したり、文脈を取り違えたりするリスクはゼロにはなりません。金融や医療、インフラといったミスが許されない領域での活用が進まない主因はここにあります。

AWSが注目する「自動推論(Automated Reasoning)」のアプローチ

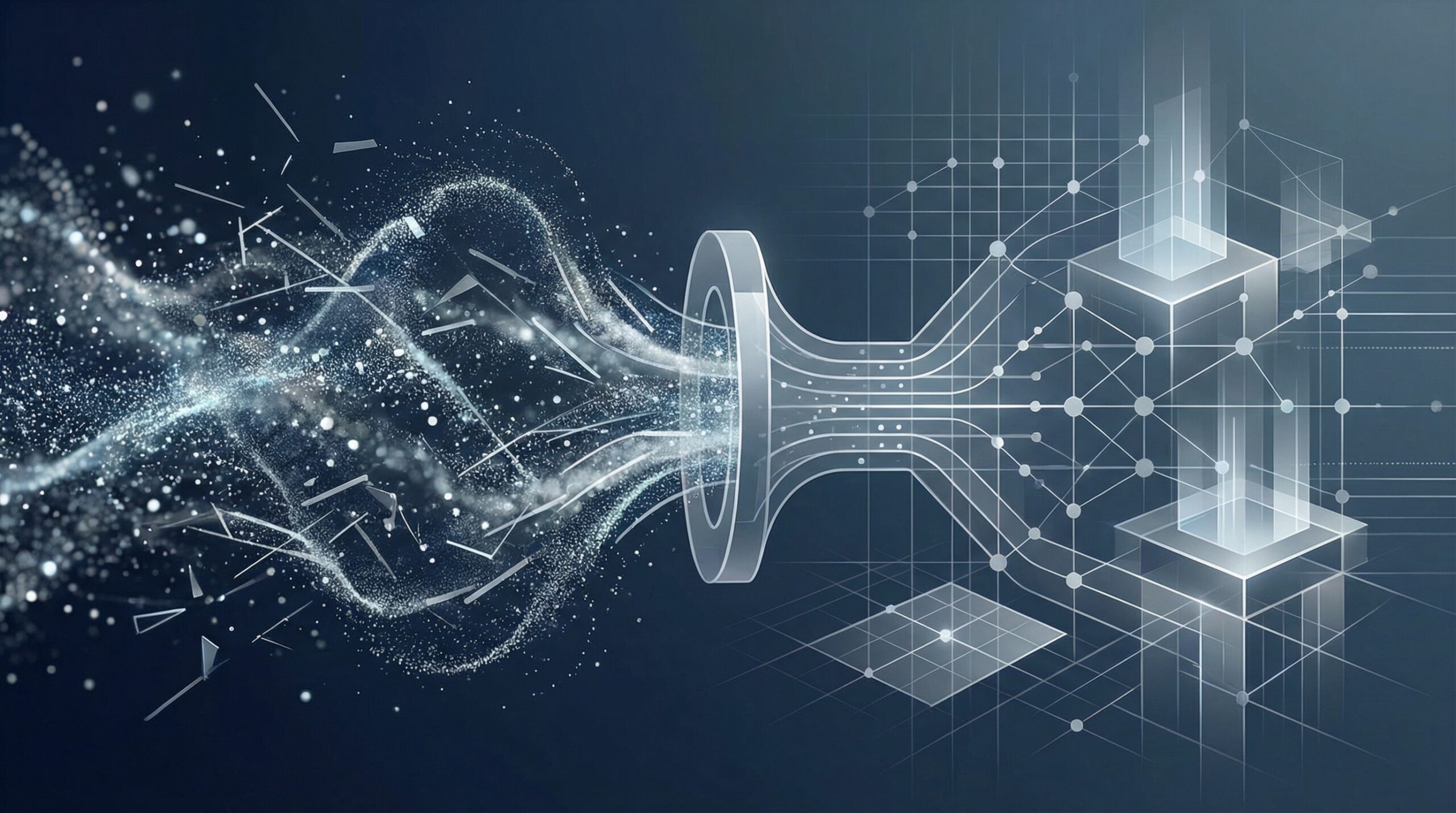

こうした中、AWS(Amazon Web Services)などのプラットフォーマーが強化しているのが、「自動推論(Automated Reasoning)」を用いたアプローチです。これは機械学習とは異なり、数学的なロジックに基づいてシステムの挙動を検証する技術です。

従来のAI対策が「もっとデータを増やす」「プロンプトを工夫する」といった確率精度を高める方向性だとすれば、自動推論は「論理的にあり得ない出力を数学的にブロックする」という「確定的(Deterministic)」なアプローチと言えます。例えば、「A部署の社員はB部署のデータにアクセスしてはならない」というルールを数学的に記述し、AIの出力がそのルールに違反していないかを生成プロセスの一部として検証するのです。

ニューラルネットワークとシンボリックAIの融合

この動きは、技術的な観点から見れば、現在のAIブームを牽引する「ニューラルネットワーク(深層学習)」と、かつての主流であった論理・記号に基づく「シンボリックAI」の融合とも捉えられます。

日本企業、特に製造業や金融業の現場では、説明可能性(Explainability)と確実性が強く求められます。「なぜその答えになったのか」がブラックボックスのままでは、稟議が通らないことも多いでしょう。自動推論のような論理検証レイヤーをLLMの外側に配置することは、AIの創造性を活かしつつ、企業が守るべきポリシー(法規制、社内規定、倫理規定)を厳格に適用するための現実解となりつつあります。

日本企業のAI活用への示唆

今回のAWSの事例やグローバルなトレンドを踏まえ、日本企業は以下の点を意識してAI実装を進めるべきです。

1. プロンプトエンジニアリング依存からの脱却

「プロンプトで『嘘をつくな』と指示する」だけでは、業務レベルのガバナンスは担保できません。人間の注意書きに頼るのではなく、システム的なガードレール(論理検証機能)をアーキテクチャに組み込む必要があります。

2. 「確率」と「論理」の役割分担

アイデア出しやドラフト作成など「創造性」が必要なタスクにはLLMの確率的な能力を、事実確認やコンプライアンスチェックなど「正確性」が必要なタスクにはルールベースや自動推論などの決定論的な仕組みを組み合わせるハイブリッドな構成を検討してください。

3. ガバナンスのコード化(Governance as Code)

日本の商習慣や複雑な法規制を、AIが理解できる自然言語のプロンプトだけで管理するのは限界があります。セキュリティポリシーやアクセス権限と同様に、AIへの制約事項もコードや数理的なルールとして定義し、自動的に適用される仕組みを構築することが、安全な本番運用への近道です。