MetaのチーフAIサイエンティストであるヤン・ルカン氏が、現在のAI開発における過度な大規模言語モデル(LLM)への注力に疑義を呈しています。生成AIブームの中で見過ごされがちな技術的限界と、日本企業が「流行」に流されずに実益を得るための戦略的視点について解説します。

「LLM-pilled」:技術的熱狂の裏側にあるリスク

MetaのAI研究を牽引するヤン・ルカン(Yann LeCun)氏が、最近の業界動向や自社の一部チームに対し、過度に「LLM-pilled(LLMという錠剤を飲まされた=LLMこそが唯一の正解だと信じ込んでいる状態)」であると批判的な見解を示したことが話題となっています。これは単なる社内の主導権争いではなく、現在のAIブームが抱える本質的な課題を浮き彫りにしています。

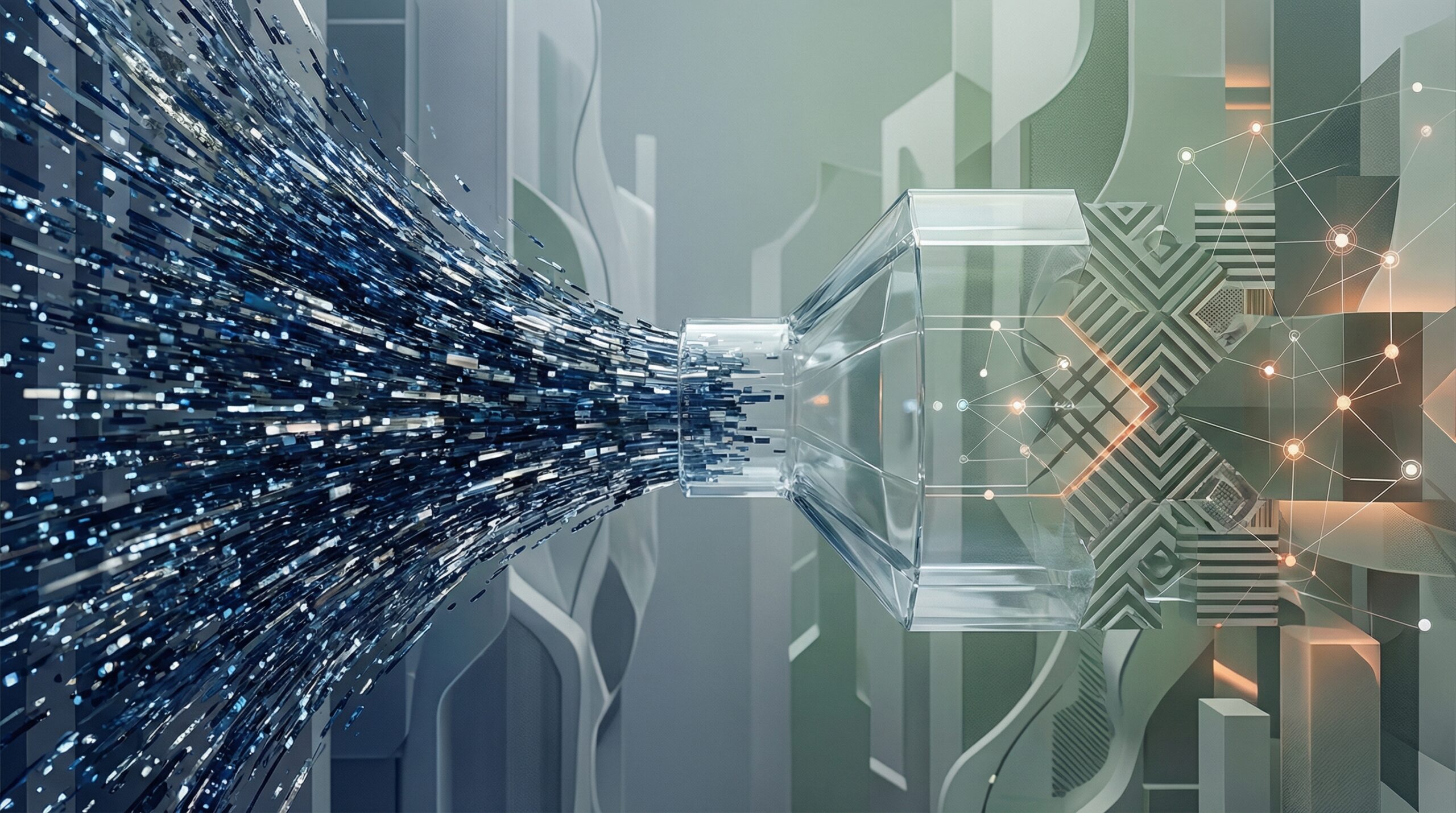

現在の生成AIの主流であるLLMは「自己回帰(Auto-regressive)」モデルと呼ばれ、確率的に「次の単語」を予測することに特化しています。これにより流暢な文章生成や翻訳、要約が可能となり、日本のビジネス現場でも議事録作成や社内ナレッジ検索(RAG)などで多大な成果を上げています。

しかし、ルカン氏が指摘するのは、LLMが「物理世界の法則」や「論理的な因果関係」を真に理解しているわけではないという点です。そのため、もっともらしい嘘(ハルシネーション)をつくリスクが消えず、複雑な推論や計画(プランニング)を要するタスクでは信頼性が低くなります。この限界を無視して、あらゆる経営課題をLLMだけで解決しようとする姿勢は、企業にとって大きなリスクとなり得ます。

言語能力と論理能力の混同を避ける

日本企業、特に製造業やインフラ産業などの「現場(Real World)」を持つ組織にとって、この議論は極めて重要です。LLMはホワイトカラー業務の効率化(DX)には強力な武器となりますが、物理的な作用や絶対的な安全性が求められる領域――例えば工場の自動制御や複雑な物流計画、金融商品の厳密なリスク計算など――に、そのまま適用するのは時期尚早です。

ルカン氏は、LLMの次に来るべきものとして「世界モデル(World Models)」や「JEPA(Joint Embedding Predictive Architecture)」といった、人間のように外界の仕組みを学習・理解できるアーキテクチャを提唱しています。これは、AIが単にテキストを生成するだけでなく、行動の結果を予測し、計画を立てられるようにするためのアプローチです。

日本企業の実務担当者は、「言葉を操るAI(LLM)」と「世界を理解するAI(次世代モデル)」を明確に区別する必要があります。現在のLLMブームに乗り遅れないことは重要ですが、同時にLLMが苦手とする「正確な論理推論」や「事実の担保」については、従来のルールベースのシステムや人間による監査、あるいは全く別のAIモデルを組み合わせるハイブリッドなアプローチが求められます。

日本企業のAI活用への示唆

今回のMeta内部での議論やルカン氏の発言を踏まえ、日本の意思決定者やエンジニアは以下の3点を意識してAI戦略を構築すべきです。

1. 「LLM一本足打法」からの脱却と適材適所

「生成AIですべて解決する」という過度な期待は捨ててください。顧客対応や文書作成など「非構造化データ」の処理にはLLMを積極採用しつつ、高い正確性が求められる基幹業務や意思決定プロセスには、従来の統計的手法やシンボリックAIを組み合わせるなど、システム全体のアーキテクチャで信頼性を担保する設計が必要です。

2. ハルシネーション・リスクへの組織的な許容度定義

日本の商習慣では「100%の正解」が求められがちですが、LLMの原理上、ゼロリスクは不可能です。どの業務であれば誤りが許容されるか、あるいは人間がチェックするフロー(Human-in-the-loop)をどこに挟むかという「運用によるガバナンス」を設計の初期段階で組み込んでください。

3. 次世代技術(世界モデル等)への目配り

現在はLLM全盛ですが、AI技術の進化は止まりません。特に日本の強みであるロボティクスや素材開発などの分野では、ルカン氏が提唱するような「物理世界を理解するAI」の実用化がブレイクスルーになる可能性があります。現在のLLM活用を進めつつも、2〜3年後の技術転換を見据え、基礎的なR&Dや情報収集のリソースを維持することが、中長期的な競争力につながります。