AWSのセキュリティブログが、商用AIサービスを悪用してFortiGateデバイスへの大規模攻撃を行う脅威アクターの存在を報告しました。これは、高度なスキルを持たない攻撃者でもAIの支援を得て大規模な攻撃が可能になったことを示唆しています。本稿では、この「脅威の民主化」という現象が日本企業のセキュリティ戦略に与える影響と、経営層や実務者がとるべき対策について解説します。

AIによる攻撃能力の底上げとスケーラビリティ

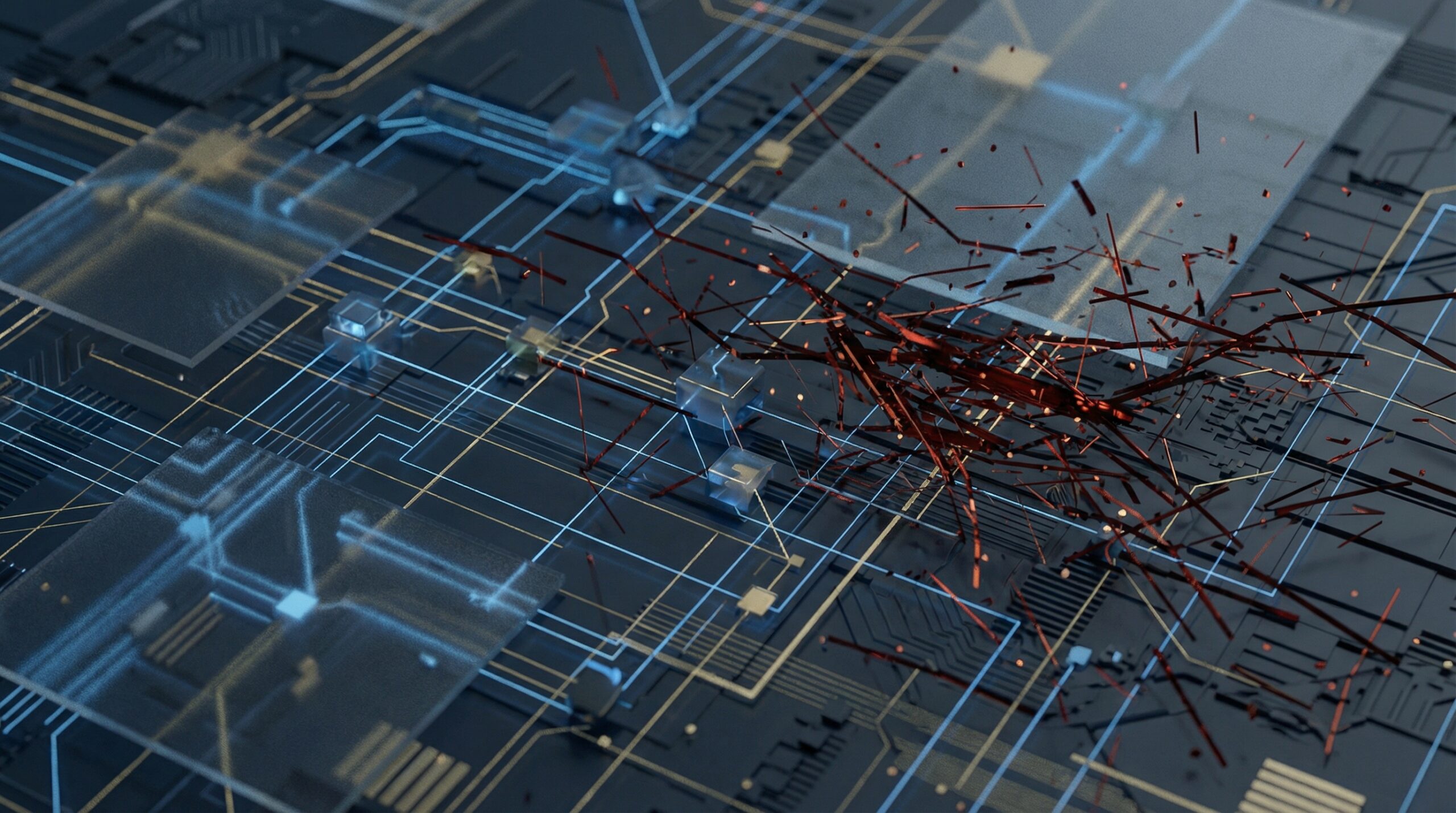

AWS Threat Intelligenceが報告した事例は、サイバーセキュリティのパラダイムシフトを象徴しています。これまで、大規模かつ標的を絞った攻撃を行うには、高度なプログラミングスキルや脆弱性に関する深い知識が必要でした。しかし、商用の生成AIサービスやLLM(大規模言語モデル)の登場により、比較的スキルの低い攻撃者(いわゆるスクリプトキディなど)であっても、複雑な攻撃コードの作成や、エラーのデバッグ、さらには攻撃スクリプトの最適化が可能になりつつあります。

特に注目すべきは、FortiGateのようなVPNやファイアウォール機器に対する攻撃が「規模(Scale)」を持って行われている点です。AIは、特定の脆弱性を持つデバイスをインターネット全体から高速に探索し、発見次第、自動的にエクスプロイト(攻撃コード)を実行するプロセスの効率を劇的に高めます。人間が手動でターゲットを選定していた時代とは異なり、AIによる自動化された攻撃は、24時間365日、休むことなく日本の企業のゲートウェイを叩き続けていると考えるべきです。

「日本語の壁」の崩壊と日本企業の脆弱性

日本企業にとって、AIを活用した脅威はインフラへの攻撃だけにとどまりません。生成AIの翻訳・文章作成能力の向上は、かつて日本企業を守っていた「日本語の壁」を無効化しつつあります。

これまでのフィッシングメールやビジネスメール詐欺(BEC)は、不自然な日本語が多用されていたため、従業員が違和感を持って検知することが容易でした。しかし、最新のLLMを悪用すれば、ネイティブレベルの自然な日本語で、文脈に応じた巧みなソーシャルエンジニアリング攻撃が可能になります。これに前述のインフラへの自動攻撃が組み合わさることで、侵入のきっかけ(初期アクセス)を作られるリスクは格段に高まっています。

また、日本企業は一度導入したセキュリティ機器を長期間(塩漬け状態で)運用する傾向があり、パッチ適用が遅れがちです。攻撃側がAIを使って既知の脆弱性を瞬時に突いてくる現在、数日〜数週間のパッチ適用の遅れが致命傷になり得ます。

AIにはAIを:防御側の進化とMLOpsの重要性

攻撃側がAIを使う以上、防御側もAIを活用しなければ対抗できません。セキュリティベンダー各社は、脅威インテリジェンスにAIを組み込み、異常検知やログ分析の自動化を進めています。

一方で、自社でAIモデルやLLMを活用したサービス開発(MLOps)を行っている企業にとっては、自社のAIモデル自体が攻撃対象になるリスク(プロンプトインジェクションやモデルの汚染など)も考慮する必要があります。攻撃者は、AIを使ってシステムの脆弱性を探すだけでなく、AIシステムそのものの振る舞いを操作しようと試みるからです。したがって、AI活用を進める企業は、従来のITセキュリティに加え、「AIセキュリティ(AI TRiSMなど)」の観点を取り入れたガバナンス体制が不可欠です。

日本企業のAI活用への示唆

AWSの事例は、AIが単なる業務効率化ツールではなく、攻撃者の武器としても「実用段階」に入ったことを示しています。日本企業は以下の3点を意識して対策を進めるべきです。

1. 「隠ぺいによるセキュリティ」からの脱却とパッチ管理の徹底

「うちは狙われない」という楽観論は通用しません。AIによる無差別かつ大規模なスキャン攻撃は、企業規模を問わず行われます。特にFortiGateのような境界防御製品への依存度が高い日本企業においては、ASM(Attack Surface Management:攻撃対象領域管理)を導入し、自社のIT資産が外部からどう見えているかを把握し、迅速にパッチを適用する体制(または自動化)を整備することが急務です。

2. 従業員教育のアップデートと多層防御

「怪しい日本語のメールに注意」という教育はもはや不十分です。生成AIによる自然な文面の攻撃を前提とし、多要素認証(MFA)の強制や、ゼロトラストアーキテクチャ(境界防御に頼らず、すべてのアクセスを検証する考え方)への移行を加速させる必要があります。

3. AIガバナンスと防御の自動化

攻撃の速度に対抗するためには、人間による監視だけでは限界があります。AIを活用したセキュリティソリューション(SOARなど)を導入し、検知から遮断までのプロセスを自動化することを検討してください。同時に、自社でAIを活用する際は、AI特有のリスク(ハルシネーション、バイアス、敵対的攻撃)を評価するガバナンスプロセスを構築し、安全なAI利用環境を整えることが、企業の社会的責任としても求められています。