「ChatGPTは死につつある」「AI界のMySpaceになるかもしれない」――SNS上で広がるこのような挑発的な言説は、単なる煽りとして片付けるべきではありません。これは、生成AI市場が「特定のチャットボット」への熱狂から、より実務的で多様な「システム実装」のフェーズへと移行している現状を映し出しています。本記事では、この市場の変化を冷静に分析し、日本企業が今後取るべきAI戦略について解説します。

「一強」時代の終わりとモデルの多様化

2022年末の登場以来、生成AIの代名詞として君臨してきたChatGPTですが、現在その優位性は絶対的なものではなくなりつつあります。Anthropic社のClaude 3.5やGoogleのGemini 1.5 Proなど、推論能力や日本語処理能力においてGPT-4と同等、あるいは特定のタスクで凌駕するモデルが登場しているからです。

「MySpaceのようになる(=先行者として市場を切り開いたが、後発のより洗練されたサービスに取って代わられる)」という比喩は、決してOpenAI社の技術力が衰えたことを意味するわけではありません。むしろ、ユーザーの選択肢が増え、LLM(大規模言語モデル)自体がコモディティ化(一般化)し始めたことを示唆しています。日本企業にとっては、特定のベンダー1社に依存するリスク(ベンダーロックイン)を回避し、用途に応じて最適なモデルを使い分ける「マルチモデル戦略」が現実的な選択肢となってきました。

「チャットUI」から「業務ワークフローへの統合」へ

ChatGPTの功績は、対話型インターフェース(チャットUI)によってAIを誰でも使えるものにした点にあります。しかし、ビジネスの現場において「チャット画面に質問を入力して回答を得る」というスタイルは、必ずしも効率的とは限りません。毎回プロンプトを入力する手間や、回答のブレは業務の安定性を損なう要因にもなります。

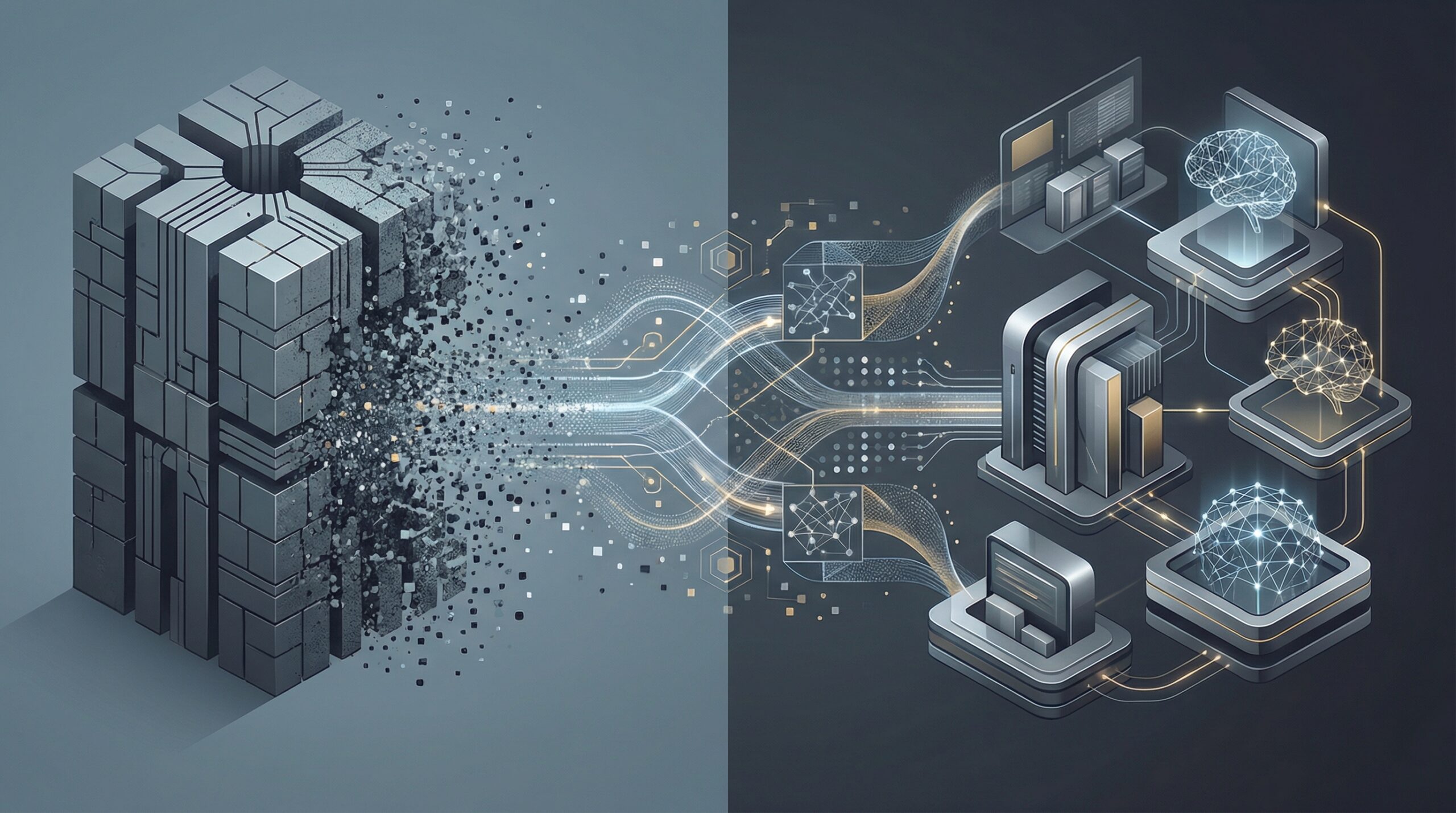

現在、世界のトレンドは「人間がAIと話す」ことから、「AIがバックグラウンドでシステムと連携して動く」方向へとシフトしています。これを「エージェント型AI」や「AIワークフロー」と呼びます。例えば、顧客からの問い合わせメールを受信した瞬間に、RAG(検索拡張生成)技術を用いて社内マニュアルを参照し、ドラフト作成からCRM(顧客管理システム)への登録までを自動で行うといった活用です。日本の現場においても、従業員に「ChatGPTを使わせる」段階から、「業務システムにLLMを組み込む」段階への脱皮が求められています。

コスト最適化とオープンモデルの台頭

もう一つの重要な視点は、コストとセキュリティです。Meta社のLlama 3に代表される高性能なオープンウェイト(オープンソースに近い形態)モデルの登場により、企業は自社環境やプライベートクラウド内でLLMを運用することが容易になりました。

機密情報の取り扱いに厳格な日本の商習慣やコンプライアンス要件において、外部APIへデータを送信することに抵抗がある企業も少なくありません。自社専用の小規模言語モデル(SLM)やオープンモデルを活用することで、データガバナンスを維持しつつ、API利用料の変動リスクを抑えるアプローチが注目されています。「何でもできる巨大なモデル」ではなく、「特定のタスクに特化した安価で安全なモデル」への需要が高まっています。

日本企業のAI活用への示唆

以上の動向を踏まえ、日本の意思決定者やエンジニアは以下の3点を意識してプロジェクトを進めるべきです。

- 「ChatGPTありき」からの脱却: 「ChatGPTで何ができるか」ではなく、「解決したい課題に最適なモデルは何か」という視点を持つこと。Azure OpenAI Serviceだけでなく、AWS BedrockやGoogle Vertex AI、あるいは国産LLMなど、複数の選択肢を比較検討できる体制を整えてください。

- UI/UXとシステム統合への注力: AIモデルの性能差は縮まっています。差別化要因は、そのAIをいかに既存の業務フローに違和感なく溶け込ませるか(UX)にあります。現場の担当者が「AIを使っている」と意識せずに恩恵を受けられるようなアプリケーション設計が重要です。

- ガバナンスと出口戦略の確保: AI分野の変化は極めて速いため、特定の技術やサービスが陳腐化するリスクを常に考慮する必要があります。プロンプトやデータを特定のプラットフォームに依存させすぎず、モデルを差し替え可能なアーキテクチャ(LLM Gatewayなど)を採用することで、将来的な技術的負債を防ぐことができます。