生成AIの社会実装が進む中、不適切な回答や情報漏洩を防ぐ「ガードレール(安全対策)」の構築が急務となっています。Cisco Blogs等の最新の議論を参考に、入力フィルタリングやコンテンツラベリングを担うOSSセーフティモデルがどこまで実用レベルにあるのか、そして日本の商習慣や言語特性においてどのようなリスク管理が必要かを解説します。

「回答の制御」という新たな課題

生成AI、特に大規模言語モデル(LLM)の企業導入において、現在もっとも関心を集めているトピックの一つが「ガードレール」の構築です。初期のPoC(概念実証)段階では「何ができるか」に焦点が当てられていましたが、実運用フェーズでは「何をさせないか」という制御が不可欠になります。

元記事のテーマとなっている「GPT-OSS-Safeguard models」のようなセーフティモデルは、ユーザーからの入力(プロンプト)に悪意が含まれていないか、あるいはAIからの出力に差別的表現や機密情報が含まれていないかを判定する、いわば「AIのためのAI」です。これらは、従来のキーワードマッチングのような単純なフィルタリングではなく、文脈を理解してリスクを判定することを目的としています。

OSSセーフティモデルの有用性と限界

Llama Guardなどに代表されるオープンソース(OSS)のセーフティモデルを活用する最大のメリットは、データプライバシーとコスト管理です。外部APIに依存せず、自社のプライベート環境内で入出力チェックを完結できるため、機密性の高い業務データを扱う日本企業にとっては魅力的な選択肢となります。

しかし、ここで問われるのが「How safe are they?(どれほど安全か?)」という点です。実務的な観点から言えば、これらのモデルは「完璧ではない」という前提に立つ必要があります。汎用的なLLMと同様、セーフティモデルも確率的に動作するため、判定ミス(偽陽性・偽陰性)は避けられません。過剰に反応して無害なビジネス文書をブロックしてしまうリスクや、逆に巧妙な「ジェイルブレイク(脱獄)」プロンプトを見逃すリスクが常に存在します。

日本語環境における特有の難しさ

日本企業が特に留意すべきは、多くのOSSセーフティモデルが英語圏の文化や価値観に基づいてトレーニングされている点です。

例えば、「職場での不適切な発言」をフィルタリングする場合、英語圏のデータセットにおける「ハラスメント」の定義と、日本のビジネス現場における「パワーハラスメント」や文脈に依存する「空気を読まない発言」のニュアンスにはズレが生じます。単にモデルを導入するだけでは、日本の商習慣にそぐわない判定を下す可能性があります。日本国内で活用するには、日本語特有の言い回しや、国内の法規制・コンプライアンス基準に合わせた追加のチューニング(微調整)や評価が不可欠です。

多層防御(Defense in Depth)の重要性

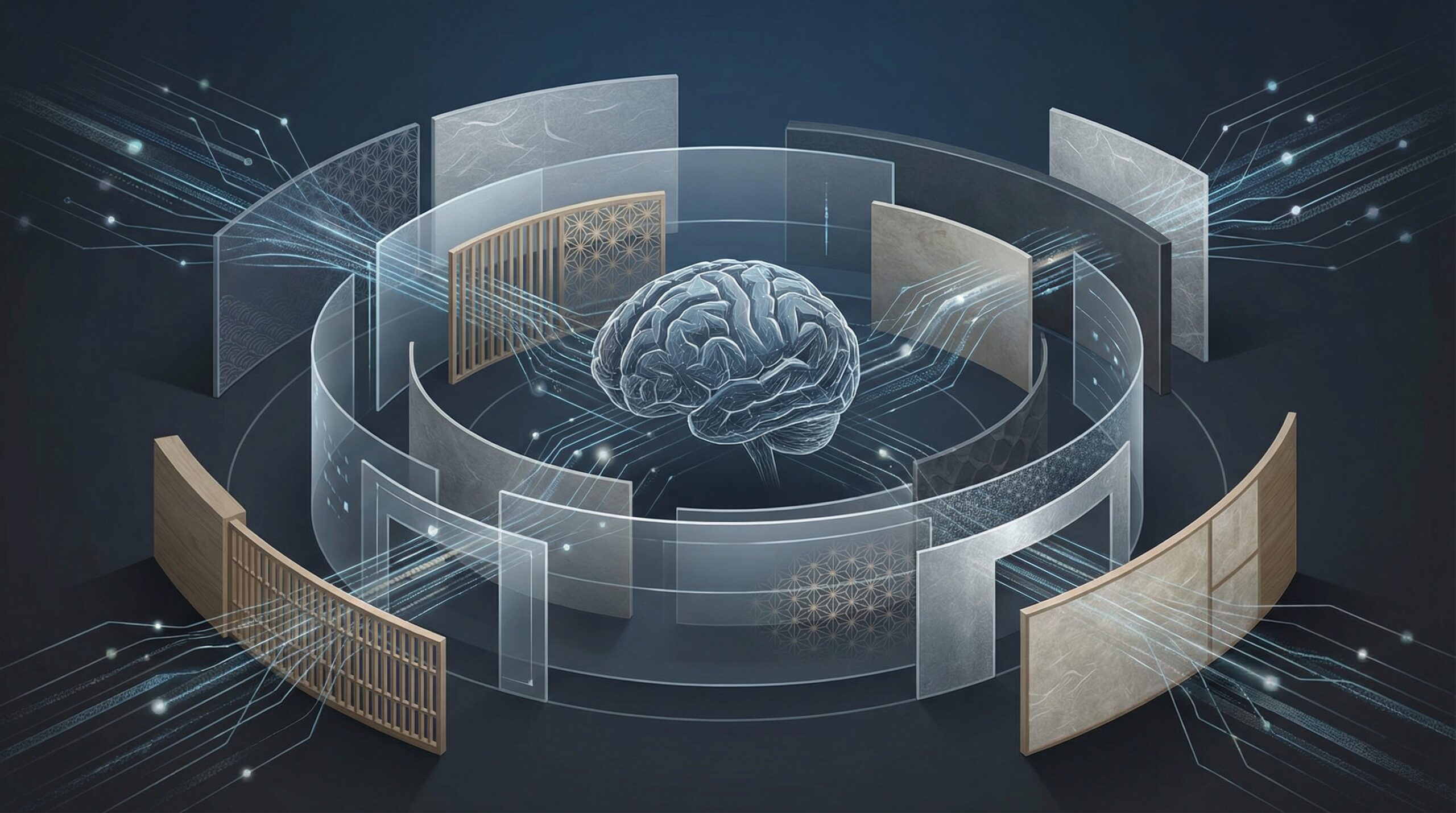

AIガバナンスの観点からは、単一のモデルに安全性を依存するのは危険です。セキュリティの世界で「多層防御」が常識であるのと同様に、AIの安全対策もレイヤーを分ける必要があります。

具体的には、正規表現によるルールベースのフィルタリング、OSSセーフティモデルによる文脈判定、そして最終的な人間による監視(Human-in-the-Loop)を組み合わせるアプローチが推奨されます。特に、顧客向けのチャットボットなど、ブランド毀損リスクが高い領域では、AI任せにせず、確実性の高いルールベース制御を優先させる判断も重要です。

日本企業のAI活用への示唆

以上の動向を踏まえ、日本企業の意思決定者やエンジニアは以下の点を意識してAI実装を進めるべきです。

1. 「安全」の定義をローカライズする

グローバル標準のモデルをそのまま使うのではなく、自社の倫理規定や日本の法的基準に基づき、何をもって「不適切」とするかの評価セットを独自に作成してください。

2. 確率的なリスクを組織として許容・管理する

「100%の安全性」を求めるとAIプロジェクトは頓挫します。セーフティモデルの限界を経営層に正しく伝え、万が一不適切な出力が発生した場合の対応フロー(免責事項の提示、緊急停止機能の実装など)を事前に整備することが、実務的な「安全性」確保につながります。

3. ハイブリッドな実装戦略

機密性が極めて高い処理にはオンプレミスのOSSセーフティモデルを使用し、一般的な対話には精度の高い商用APIのフィルタリング機能を併用するなど、コストとリスクのバランスを見極めたアーキテクチャ設計が求められます。