生成AIの実用化フェーズにおいて、GPUメモリ(HBM)の容量不足とコスト高騰が大きな課題となっています。韓国SKハイニックスが提唱する「HBMとHBF(High Bandwidth Flash)のハイブリッド構成」は、このボトルネックを解消する可能性があります。本記事では、この技術動向がもたらすインフラの変化と、コスト対効果を重視する日本企業のAI戦略への影響を解説します。

LLM推論における「メモリの壁」とHBMの限界

現在、大規模言語モデル(LLM)の推論環境において、最も深刻なボトルネックとなっているのがGPUに搭載されるメモリ、すなわちHBM(High Bandwidth Memory)の容量制限です。モデルの大規模化に伴い、パラメータやKVキャッシュ(推論時の計算結果の一時保存)をすべてHBM上に保持することが困難になっています。

HBMが満杯になると、システムは低速なローカルSSDやメインメモリからデータを読み込む必要が生じます。HBMの帯域幅が秒間数テラバイト級であるのに対し、標準的なSSDは桁違いに遅いため、このデータ転送が推論速度(レイテンシ)を劇的に悪化させる要因となります。

SKハイニックスが描く「HBM + HBF」ハイブリッド階層

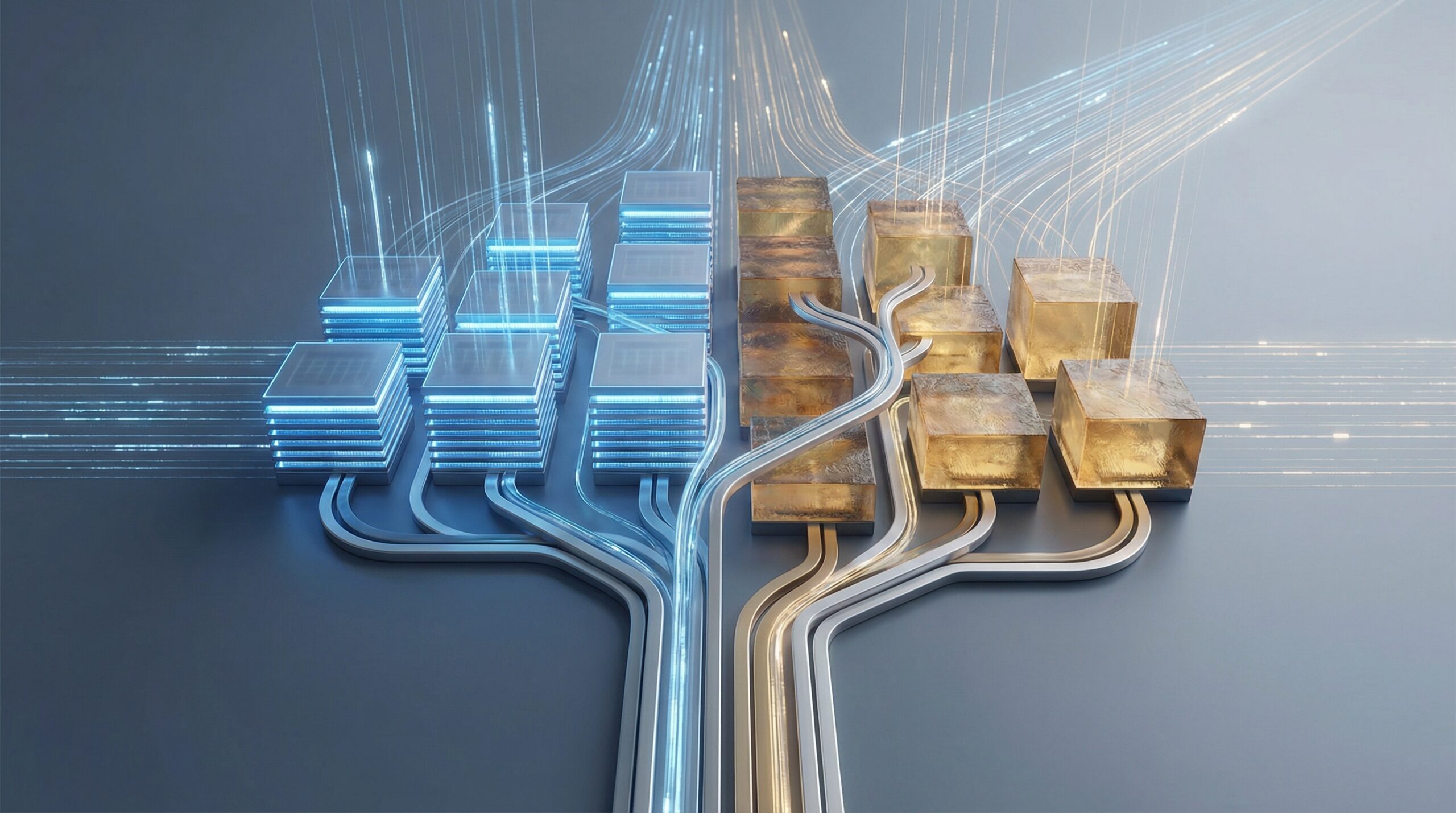

この課題に対し、SKハイニックスなどのメモリベンダーは、HBM単体での処理にこだわらず、より安価で大容量なストレージクラスメモリを組み合わせるハイブリッドなアプローチを提唱し始めています。記事にある「HBF(High Bandwidth Flash)」のような技術は、従来のSSDよりも高速なI/O性能を持ち、HBMを補完する「第2のメモリ階層」として機能することを意図しています。

このアーキテクチャの狙いは明確です。頻繁にアクセスされるホットデータは超高速なHBMに置き、頻度が下がるが即座に必要となるデータ(長いコンテキスト履歴など)をHBFに配置することで、パフォーマンスの低下を最小限に抑えつつ、システム全体のメモリ容量を劇的に拡張することです。これにより、1台のサーバーで稼働できるモデルのサイズや同時接続数(スループット)を大幅に向上させることが期待されます。

日本企業のAI活用への示唆

日本国内において、コスト意識の高いエンタープライズ領域でLLMを導入する際、この技術トレンドは重要な意味を持ちます。以下に、意思決定者やエンジニアが考慮すべきポイントを整理します。

1. 推論コストの最適化とオンプレミス回帰の可能性

日本企業では、データガバナンスの観点から機密情報を社外に出したくないというニーズが強く、オンプレミスやプライベートクラウドでのLLM運用(ローカルLLM)への関心が高まっています。しかし、高性能なGPUサーバーの調達コストが障壁となっていました。メモリ階層化技術が進めば、最高スペックのGPUを大量に並べずとも、現実的なコストで大規模モデルを運用できる可能性が出てきます。「為替の影響を受けやすいAPI従量課金」から、「固定資産としての自社インフラ」へ投資判断が揺り戻す契機になるかもしれません。

2. RAG(検索拡張生成)におけるコンテキスト長の拡大

日本の実務では、社内ドキュメントを検索して回答させるRAGの需要が非常に高いです。RAGの精度を高めるには、より多くの関連文書をプロンプトに含める必要がありますが、これはメモリ消費量を増大させます。HBM+HBFのような構成が実用化されれば、より長いコンテキストウィンドウを低コストで扱えるようになり、複雑な社内規定や技術文書を参照するAIの回答精度向上が期待できます。

3. 技術選定における「待ち」と「攻め」のバランス

このハイブリッド技術は有望ですが、ハードウェアだけでなく、それを制御するソフトウェアスタック(OS、ドライバ、推論ライブラリ)の対応が不可欠です。エンジニアやPMは、現在のGPUリソースでスモールスタートしつつ、次世代のメモリ技術がサーバーベンダーから提供され始めたタイミングで、インフラの刷新やスケールアップを検討するというロードマップを描くのが賢明です。過度なスペック競争に巻き込まれず、「自社のタスクに必要なレイテンシとスループットは何か」を見極める設計力が、これまで以上に問われることになります。