生成AIの急速な普及に伴い、計算資源への需要が爆発的に増加する中、HPE Labsをはじめとするグローバルな研究機関では、単なる処理性能の向上だけでなく、エネルギー効率や信頼性を抜本的に変革する次世代技術の研究が進んでいます。本稿では、AIモデルの背後にあるインフラ技術の動向を解説し、日本企業が長期的なAI戦略を描く上で考慮すべき「物理的制約」とその解決策について考察します。

モデル開発競争の裏で進む「計算基盤」の革新

現在、世界のAIトレンドはGPT-4やClaude 3といった大規模言語モデル(LLM)の性能競争に注目が集まりがちです。しかし、HPE Labs(Hewlett Packard Enterpriseの研究機関)のようなハードウェアにルーツを持つ研究機関が注力しているのは、それらのモデルを動かすための「足回り」、すなわち次世代コンピューティング基盤の革新です。

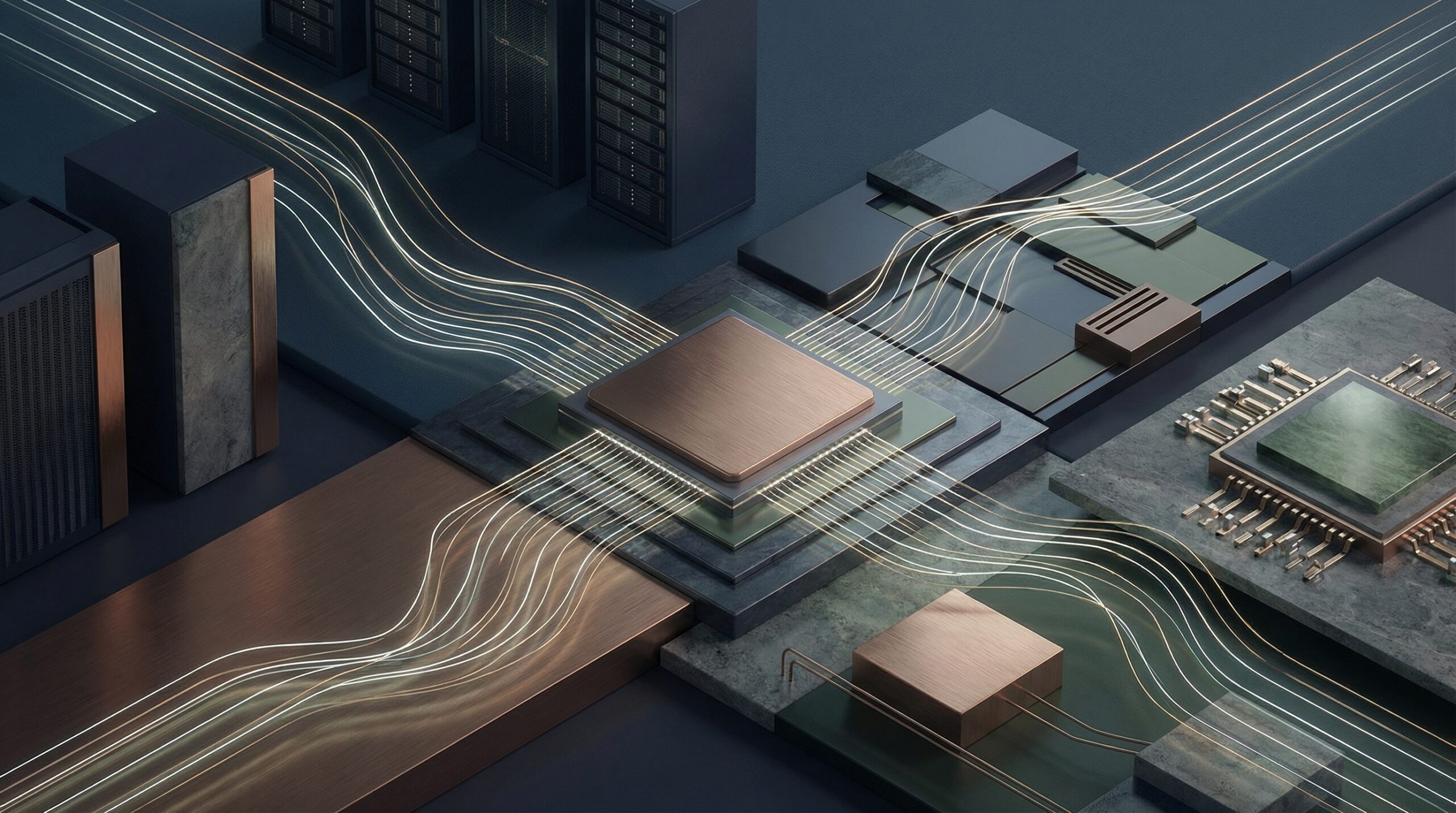

AIモデルのパラメータ数が兆単位で増加する中、従来のCPUやGPUを並べただけのアーキテクチャでは、データ転送のボトルネックや消費電力の限界に直面しています。これに対し、光インターコネクト(光通信技術をチップ間通信に応用する技術)や、メモリと演算装置をより密接に統合する新しいアーキテクチャの研究が進んでいます。これらは、AIの学習や推論にかかる時間を短縮するだけでなく、インフラ全体のコスト構造を根本から変える可能性を秘めています。

「サステナブルなAI」は日本企業の経営課題

日本企業にとって特に切実なのが、AI活用に伴うエネルギーコストの問題です。日本は欧米と比較しても産業用電気料金が高水準にあり、データセンターの電力容量も逼迫しつつあります。無邪気に大規模モデルを導入すれば、ランニングコストが事業の収益性を圧迫しかねません。

グローバルの研究開発の現場では、単に「速い」だけでなく「省電力である」ことがAIインフラの必須要件になりつつあります。いわゆる「Green AI」の考え方です。推論時の消費電力を抑えるためのモデル軽量化技術や、液体冷却などの冷却技術の進化、さらにはアナログコンピューティングのような非ノイマン型アプローチまで、エネルギー効率を劇的に高める研究が進んでいます。日本企業がAI基盤を選定・構築する際は、初期導入コストだけでなく、この「電力対効果(Performance per Watt)」を厳密に評価する必要があります。

エンタープライズグレードの信頼性とセキュリティ

研究室レベルの技術が実用段階に入るにつれ、焦点は「機能の実証」から「信頼性の確立」へとシフトしています。企業が基幹業務にAIを組み込む場合、確率的に動作するAIの挙動をいかに制御し、セキュリティを担保するかが課題となります。

特に、AIに対する敵対的攻撃(Adversarial Attacks)や、学習データの汚染(Data Poisoning)といった新たな脅威に対し、ソフトウェア層だけでなくハードウェア層を含めた防御策が研究されています。日本の製造業や金融業など、高い品質基準とコンプライアンスが求められる業界では、オープンなモデルを利用しつつも、インフラ側でデータの機密性やプロセスの完全性を担保する「Trusted AI(信頼されるAI)」のアプローチが求められます。

日本企業のAI活用への示唆

以上の技術動向を踏まえ、日本のビジネスリーダーやエンジニアは以下の点を意識してAI戦略を構築すべきです。

1. インフラコストを「隠れた負債」にしない

クラウドAPIを利用する場合でも、オンプレミスで基盤を構築する場合でも、その背後にある計算コストと電力消費は最終的に価格に転嫁されます。長期的には、省電力技術に優れたインフラを選択することが競争力に直結します。

2. ハイブリッドな環境構築の検討

機密性の高いデータや低遅延が求められる処理は、自社管理下の高効率なエッジ/オンプレミス環境で行い、汎用的な処理はパブリッククラウドに任せるといった使い分けが重要です。データ主権(Data Sovereignty)の観点からも、国内または自社内に制御可能な計算基盤を持つことの重要性は増しています。

3. 技術の「目利き力」を高める

AIは魔法ではなく、物理的な計算資源の上で動くプログラムです。ベンダーの謳う「最新AI」という言葉に踊らされず、その裏側にあるアーキテクチャが自社の規模やデータの性質、そして日本の商習慣や法規制(改正個人情報保護法や著作権法など)に適合しているかを見極める視点が、エンジニアだけでなく経営層にも求められます。