OpenAIによるモデル更新や移行作業に伴い、ChatGPTにおいて断続的な接続エラーや遅延が報告されています。本記事では、この事象を単なる一時的な障害としてではなく、外部AIモデルに依存するビジネスが直面する構造的なリスクと捉え、日本企業が講じるべきシステム設計や運用体制について解説します。

モデル刷新に伴う「過渡期」のシステム不安定性

最近、ChatGPTユーザーから接続エラーや応答の遅延(ラグ)が多数報告されています。一部の海外メディア(Happy Magなど)では、これをOpenAIが旧モデルから次世代モデル(報道ではGPT-5.2という名称も取り沙汰されています)へ移行するプロセスに伴う影響であると報じています。

AI業界の慣例として、大規模なモデルのロールアウトやバックエンドのインフラ刷新時には、計算リソースの逼迫や予期せぬバグにより、サービスレベルが一時的に低下することが珍しくありません。特にLLM(大規模言語モデル)は推論コストが極めて高く、数億人規模のユーザーを抱えるサービスでのバージョン移行は、巨大なサーバー負荷を伴います。

ここから読み取るべきは、「最新モデルへの期待」ではなく、「SaaS型AIを利用する以上、提供側の都合による不安定化は避けられない」という冷徹な事実です。

SaaS型AI利用における「可用性」と日本企業の課題

日本の商習慣では、システムに対して「止まらないこと(高可用性)」や「常に一定の品質であること」が厳しく求められます。しかし、OpenAIを含む多くの生成AIベンダーは、アジャイルな開発スタイルを採用しており、予告期間の短い仕様変更やメンテナンスが発生しがちです。

企業が業務フローや顧客向けサービスにChatGPTなどのAPIを組み込む場合、「APIはいつか止まるもの」「応答速度は変動するもの」という前提に立つ必要があります。特に、日本の企業がSLA(サービス品質保証)を重視する場合、一般向けのChatGPTや不透明なベータ版APIではなく、Azure OpenAI Serviceのような、よりエンタープライズ要件に即した環境を選択するか、あるいは障害発生時のオペレーションを事前に定義しておくことが不可欠です。

特定のモデルバージョンに依存しない設計思想

今回の報道にあるような「モデルの移行」は、システム障害だけでなく、出力精度の変化というリスクも孕んでいます。新しいモデルが必ずしも自社のユースケースにおいて優れているとは限りません(いわゆる「性能劣化」や「性格の変化」)。

MLOps(機械学習基盤の運用)の観点からは、プロンプトやアプリケーションのロジックを特定のモデルバージョンに過剰適合(オーバーフィッティング)させないことが重要です。プロンプトエンジニアリングでギリギリの調整を行っていると、モデルが「GPT-4」から「GPT-5.x」へ変わった瞬間に、期待した回答が得られなくなる可能性があります。

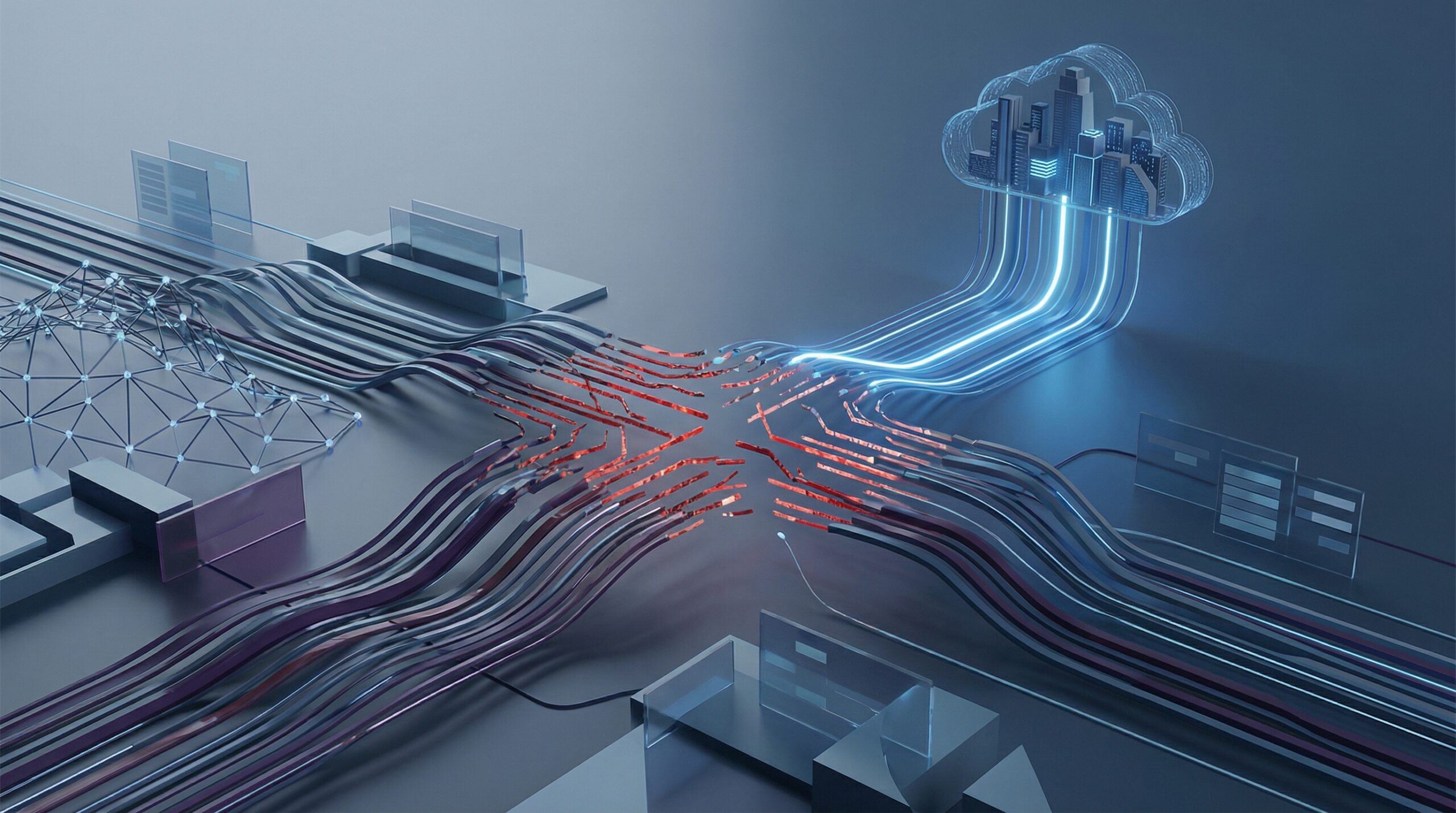

開発現場では、LangChainなどのオーケストレーションツールを活用し、モデルの切り替えを容易にする抽象化レイヤーを設けることや、回答の品質を自動評価するテストセットを整備し、モデル更新時に即座に影響範囲を特定できる体制づくりが求められます。

日本企業のAI活用への示唆

今回の接続不安定のニュースは、AI活用を進める日本企業に対して、以下の重要な示唆を与えています。

- マルチモデル戦略の検討:

単一のAIベンダーやモデルに依存すると、そのベンダーの障害や方針変更がそのまま事業リスクになります。OpenAIだけでなく、Anthropic(Claude)やGoogle(Gemini)、あるいは国産LLMなど、複数の選択肢をバックアップとして持っておく「冗長化」が、BCP(事業継続計画)の観点から重要性を増しています。 - 「枯れた技術」と「最新技術」の使い分け:

PoC(概念実証)や新規事業開発では最新モデル(GPT-4oや将来のGPT-5など)を積極的に試しつつ、安定性が求められる基幹業務には、動作検証が済んだ安定版モデル(LTS: Long Term Support的な位置づけのもの)を採用するなど、適材適所のポートフォリオ管理が必要です。 - エラーハンドリングの高度化:

ユーザー体験(UX)を守るため、AIからの応答が遅延・失敗した場合に、「ただエラーを出す」のではなく、ルールベースの回答に切り替えたり、キャッシュを返したりするなどのフェールセーフな設計を実装レベルで徹底する必要があります。