デバイス識別技術大手のFingerprintが、正当なAIエージェントと悪意あるボットを識別する新機能を発表しました。これは単なる新製品のニュースではなく、企業が「すべての自動化をブロックする」時代から、「ビジネスに有益なAIを受け入れる」時代へと移行しなければならないことを示唆しています。

「人間かボットか」という二元論の限界

これまでのWebセキュリティ、特に不正検知の領域では、「人間によるアクセスか、プログラム(ボット)によるアクセスか」を判別することが最優先事項でした。CAPTCHA(画像選択による認証)やWAF(Webアプリケーションファイアウォール)は、基本的に人間以外のアクセスを遮断するために設計されています。

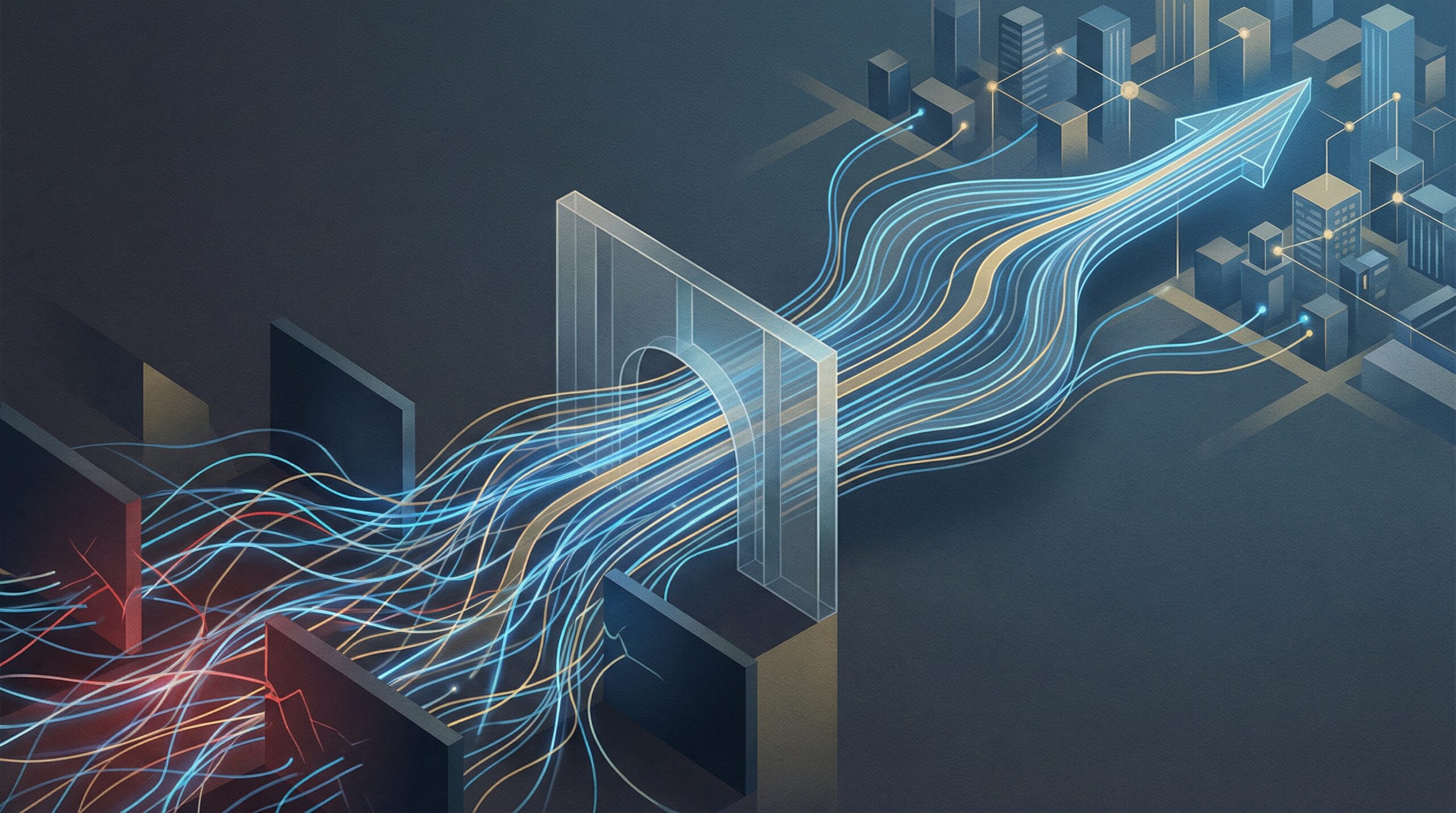

しかし、Fingerprintが発表した「Authorized AI Agent Detection(認可されたAIエージェント検知)」というコンセプトは、この前提が崩れつつあることを示しています。生成AIの進化により、ユーザーの代わりにWebサイトを閲覧し、情報の収集や予約、購買代行を行う「AIエージェント」が普及し始めているからです。これらはプログラムによるアクセスですが、その背後には正当な顧客やビジネスパートナーが存在します。

「良きエージェント」をブロックする機会損失

もし企業が従来通り「ボット=悪」として一律に遮断し続けた場合、どのようなリスクがあるでしょうか。最大のリスクは、AIエージェントを利用して効率的に購買や契約を行おうとする顧客を門前払いしてしまう「機会損失」です。

例えば、ユーザーが「最安値の旅行プランを探して予約して」とAIアシスタントに指示したとします。旅行代理店のサイトが強力なボット対策でこのAIエージェントをブロックすれば、そのサイトは比較対象から外され、売上を逃すことになります。これからのEコマースやSaaSにおいては、人間が見やすいUI(ユーザーインターフェース)だけでなく、AIエージェントがアクセスしやすい環境、あるいは少なくともAIエージェントを敵視しないセキュリティポリシーが求められます。

技術的な識別とガバナンスの課題

もちろん、すべてのボットを受け入れるわけにはいきません。スクレイピングによるコンテンツ盗用、在庫の買い占め、クレデンシャルスタッキング(パスワードリスト攻撃)などを行う悪意あるボットは、依然として脅威です。

Fingerprintの技術的なアプローチは、AIツールの一般的な動作パターンや署名を解析し、それが「信頼できる自動化ツール(例えば、Googleの検索ボットや有名なAIアシスタント)」なのか、未知の攻撃ツールなのかを識別することにあります。しかし、技術的な識別精度には限界もあります。攻撃者が「良きエージェント」を偽装するリスクも常に存在するため、セキュリティ担当者は「検知」と「防御」のバランスを慎重に設計する必要があります。

日本企業のAI活用への示唆

労働人口の減少が進む日本において、業務の自動化やAIエージェントの活用は避けて通れない道です。今回のニュースを起点に、日本企業の実務担当者が検討すべきポイントは以下の3点です。

1. セキュリティポリシーの再定義

「ボットはすべて遮断する」という従来のセキュリティポリシーを見直す時期に来ています。自社のサービスにおいて、どのような自動化アクセスであれば許容するのか(例:価格比較サイトのクローラー、顧客代理のAIなど)、ビジネス部門とセキュリティ部門が連携してガイドラインを策定する必要があります。

2. APIエコノミーへの回帰と整備

AIエージェントがWeb画面(HTML)を解析して操作するのは、本来非効率でエラーが起きやすい方法です。AIエージェント時代を見据えるなら、正規の連携手段としてAPIを整備・公開し、認証されたエージェントにはAPI経由でのアクセスを促すのが、セキュリティと利便性を両立する最も健全なアプローチです。

3. 「AI顧客」を想定したUX設計

将来的には、Webサイトの訪問者の一定割合がAIエージェントになる可能性があります。人間向けの視覚的な訴求だけでなく、AIが情報を正確に読み取れる構造化データ(Schema.orgなど)の実装や、規約(robots.txtやai.txt)の適切な記述が、SEO(検索エンジン対策)だけでなく「AIO(AI最適化)」として重要になります。