NVIDIAのジェンスン・フアン氏とイーライリリーのデビッド・リックス氏による対談は、生成AIの適用範囲がデジタル空間を超え、創薬や材料開発といった「物理世界」のR&Dプロセスを根本から変革しつつあることを示しています。本記事では、この対話で語られた「生成生物学」や「クローズドループ」の概念を紐解き、日本の製造業や研究開発組織が直面する課題と、そこから得られる実務的な知見を解説します。

「スクリーニング」から「生成」へ:R&Dのパラダイムシフト

これまで製薬業界や材料科学の分野では、膨大な候補物質のライブラリから有望なものを探し出す「スクリーニング」のアプローチが主流でした。しかし、NVIDIAとイーライリリーの対話で強調されたのは、生成AI技術を用いた「ジェネレーティブ・バイオロジー(生成生物学)」への移行です。

LLM(大規模言語モデル)が次に来る単語を予測して文章を生成するように、創薬AIはタンパク質の構造や化学反応を学習し、ターゲットとなる受容体に結合する全く新しい分子構造を「生成」します。これは、既存のデータセットに存在しない解決策をAIが提案可能になることを意味しており、日本の強みである素材産業(マテリアルズ・インフォマティクス)においても同様のパラダイムシフトが起こりつつあります。

「ウェットラボ」とAIをつなぐクローズドループ

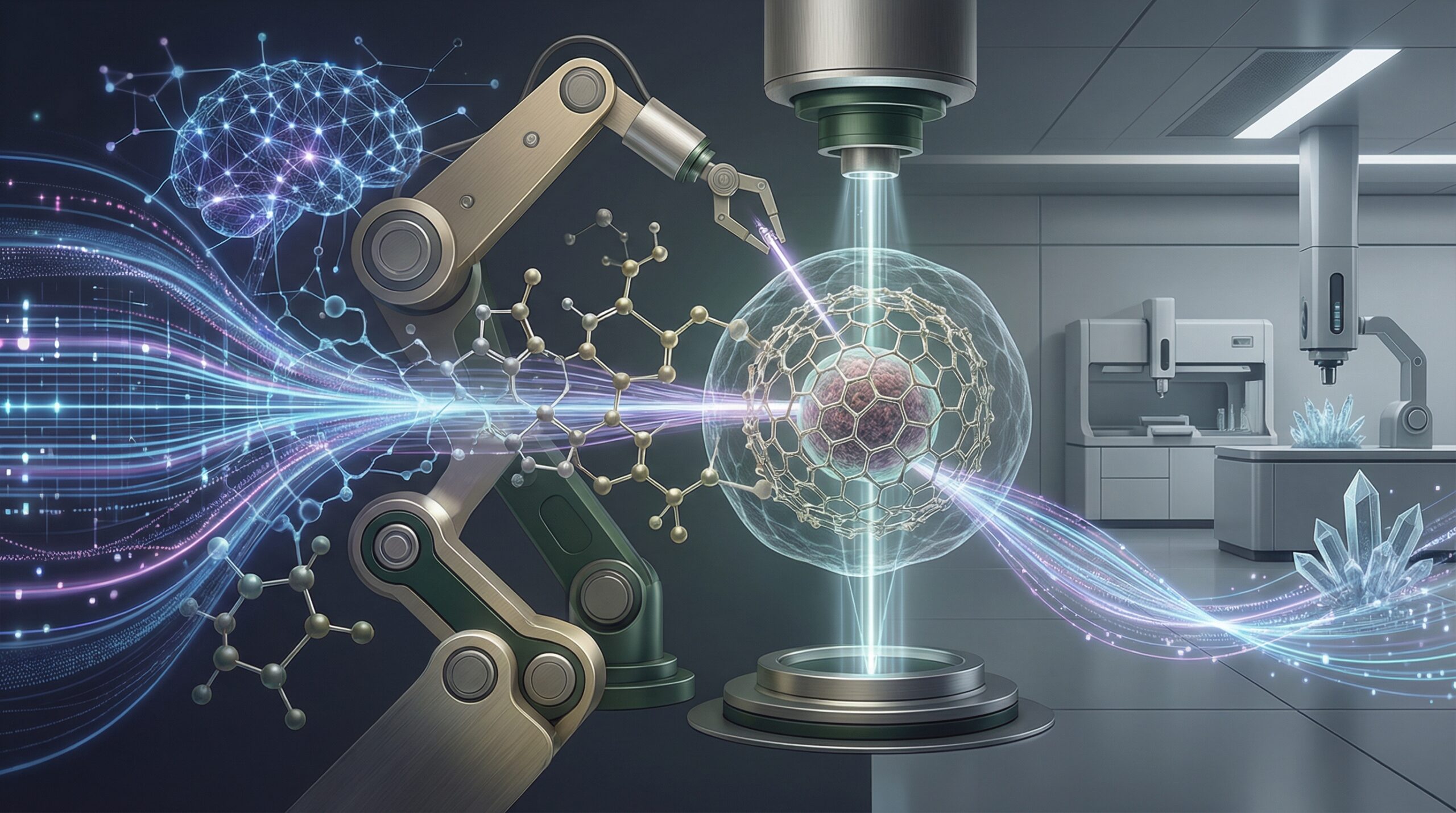

生成AIが提案した分子構造は、あくまで計算上の予測に過ぎません。ここで重要となるのが、物理的な実験を行う「ウェットラボ」の自動化と、そこから得られるデータの還流です。対談でも触れられた「ロボティック・ウェットラボ」と「クローズドループ」の概念は、AI活用の成否を分ける重要な要素です。

具体的には、以下のようなサイクルを構築します。

- AIによる仮説生成:生成モデルが有望な分子構造や配合を提案。

- ロボットによる自動実験:提案に基づき、自動化されたラボ設備で合成・評価を実行。

- 実データによる再学習:実験結果(成功・失敗問わず)をAIにフィードバックし、精度を向上させる。

このプロセスにおいて、実験データは単なる結果記録ではなく、AIモデルを鍛えるための「燃料」となります。日本企業においても、実験機器とデータ基盤をAPIで接続し、人手を介さずにデータを収集・学習させるMLOps(Machine Learning Operations)の体制構築が急務となります。

ハルシネーションと実験コストのバランス

生成AIの実務適用において常に課題となるのが「ハルシネーション(もっともらしい嘘)」です。創薬や材料開発において、AIが物理法則的に不可能な構造や、毒性のある物質を提案するリスクはゼロではありません。

しかし、デジタル空間でのチャットボットとは異なり、R&D分野では「物理実験」という究極の検証フェーズが存在します。重要なのは、AIの提案を鵜呑みにすることではなく、AIによって「実験すべき候補」を絞り込み、失敗のコストを下げることです。シミュレーション段階で不適切な候補を排除し、高確率なものだけをウェットラボに回すことで、開発サイクル全体のアジリティを高めることが目的となります。

日本企業のAI活用への示唆

今回のNVIDIAとイーライリリーの事例は、AIが単なる「効率化ツール」から「発明のパートナー」へと進化していることを示唆しています。日本の産業界、特にR&D部門を持つ企業に向けた示唆は以下の通りです。

1. 自社データの「AIレディ」化を急ぐ

外部の汎用モデルを利用するだけでは差別化は困難です。過去数十年にわたる実験データ(失敗データ含む)や、熟練研究者の暗黙知を構造化データとして整備し、自社専用のモデルをファインチューニングできる環境を整えることが競争力の源泉となります。

2. ロボティクスとAIの統合領域への投資

日本はロボティクス技術に強みを持ちますが、データ解析(AI)と物理制御(ロボット)が組織的に分断されているケースが散見されます。実験自動化とAI解析をセットで捉え、ITエンジニアとドメインエキスパート(研究者)が同じチームで開発を進めるクロスファンクショナルな体制が必要です。

3. 知財・ガバナンスの再定義

AIが生成した物質や配合の特許性、あるいは開発プロセスにおけるデータセキュリティに関しては、法的な解釈が現在進行形で議論されています。技術導入と並行して、AIガバナンスの専門家を交えたリスク管理体制を構築し、ブラックボックス化しやすいAIの判断根拠を可能な限り追跡可能(Traceable)にしておくことが、将来的なコンプライアンスリスクの低減につながります。