生成AIの活用は、単なるチャットボットから、自律的に判断を下す「AIエージェント」へと進化しています。しかし、企業が実務でエージェントを導入するためには、ブラックボックス化を避け、意思決定のプロセスを透明化する必要があります。本稿では、LLM単体に依存せず、「意味層」や「因果推論層」を組み合わせることで、信頼性と監査可能性を担保するアーキテクチャについて解説します。

実務における「LLM単体」の限界とリスク

現在、多くの日本企業が生成AIの導入を進めていますが、その多くはRAG(検索拡張生成)を用いた社内ナレッジ検索や、定型文の作成支援にとどまっています。次のステップとして期待されているのが、複雑なタスクを自律的に遂行する「AIエージェント」ですが、ここで壁となるのがLLM(大規模言語モデル)特有の確率的な挙動です。

LLMは「次に来るもっともらしい言葉」を予測することには長けていますが、厳密な論理的判断や、事実に基づいた因果関係の推論を常に正確に行えるわけではありません。金融、製造、医療といったミスが許されない領域において、「なぜその判断をしたのか」を事後検証(監査)できないシステムは、コンプライアンスやガバナンスの観点から導入が困難です。

信頼性を担保する3層アーキテクチャ

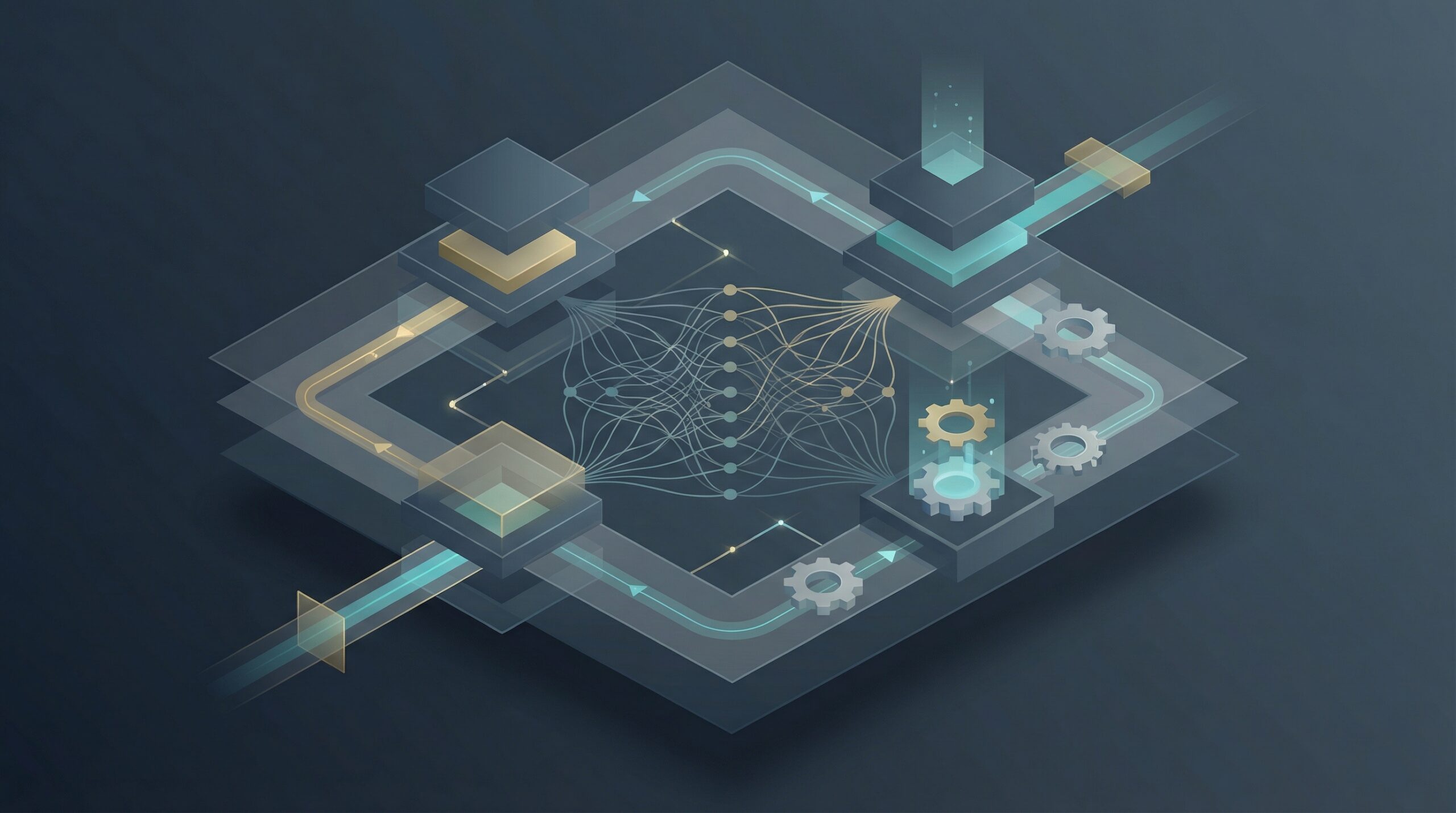

こうした課題に対し、グローバルなAI開発の現場では、LLMに全ての処理を委ねるのではなく、役割を分担させる「階層的アプローチ」が注目されています。具体的には、以下の3つのレイヤーを組み合わせる考え方です。

1. LLMによる思考連鎖(Chain-of-Thought)層

ここは、ユーザーとの対話の滑らかさや、タスクの分解を担当する層です。LLMの言語能力を活かし、複雑な指示を「思考の連鎖(Chain-of-Thought)」によってステップごとのタスクに落とし込みます。しかし、ここでは最終的な事実認定や意思決定は行わせず、あくまで「コーディネーター」としての役割に徹させることが重要です。

2. セマンティック(意味・コンテキスト)層

企業が保有する正確なデータやルールを管理する層です。ナレッジグラフやベクトルデータベースを用い、用語の定義、社内規定、商品スペックなどの「正解」となるコンテキストを提供します。この層がガバナンスの要となり、AIが勝手に事実を捏造(ハルシネーション)するリスクを抑制します。

3. 因果推論(Causal Reasoning)層

統計的な相関関係しか見ないLLMの弱点を補うため、「Xが起きればYになる」という因果関係に基づいた論理判断を行う層です。数理最適化エンジンやルールベースのシステム、あるいは因果AIモデルなどがここに該当します。これにより、過去のデータの学習だけでは導き出せない、論理的に正しい意思決定を担保します。

「説明責任」を果たせるAIシステムの構築

このアーキテクチャの最大のメリットは、「検証可能性(Verifiability)」と「監査可能性(Auditability)」が向上することです。

もしAIエージェントが誤った判断をした場合、LLM単体のシステムでは「プロンプトが悪かったのか」「モデルの学習データが偏っていたのか」の切り分けが困難です。しかし、役割を層に分けることで、「言語理解は正しかったが、参照したデータ(セマンティック層)が古かった」あるいは「データは正しかったが、推論ロジック(因果推論層)に矛盾があった」といった原因特定が容易になります。

品質管理に厳しい日本の商習慣において、エラーの原因を特定し、再発防止策を説明できることは、AIシステムを本番環境で運用するための必須条件と言えます。

日本企業のAI活用への示唆

日本企業が今後、高度なAIエージェントを開発・導入していく上で、以下の点が重要な指針となります。

- プロンプトエンジニアリングへの過度な依存からの脱却:

複雑な業務ロジックをすべてプロンプト(指示文)だけで制御しようとすると、挙動が不安定になり、保守も困難になります。LLMはあくまで「インターフェース」と捉え、判断ロジックや知識ベースを切り出した設計を行うべきです。 - 「あえて枯れた技術」とのハイブリッド:

因果推論やルールベースのエンジンは、AIブーム以前からある技術ですが、透明性は非常に高いです。最新のLLMと、既存の確実なロジックを組み合わせるハイブリッド構成こそが、日本企業の求める「安心・安全なAI」への近道です。 - ガバナンスとデータ整備の同期:

セマンティック層を構築するには、社内データの整備(構造化)が不可欠です。AI導入を単なるツール導入と捉えず、自社のナレッジを「AIが理解できる形(ナレッジグラフ等)」に再構築する契機として捉える必要があります。