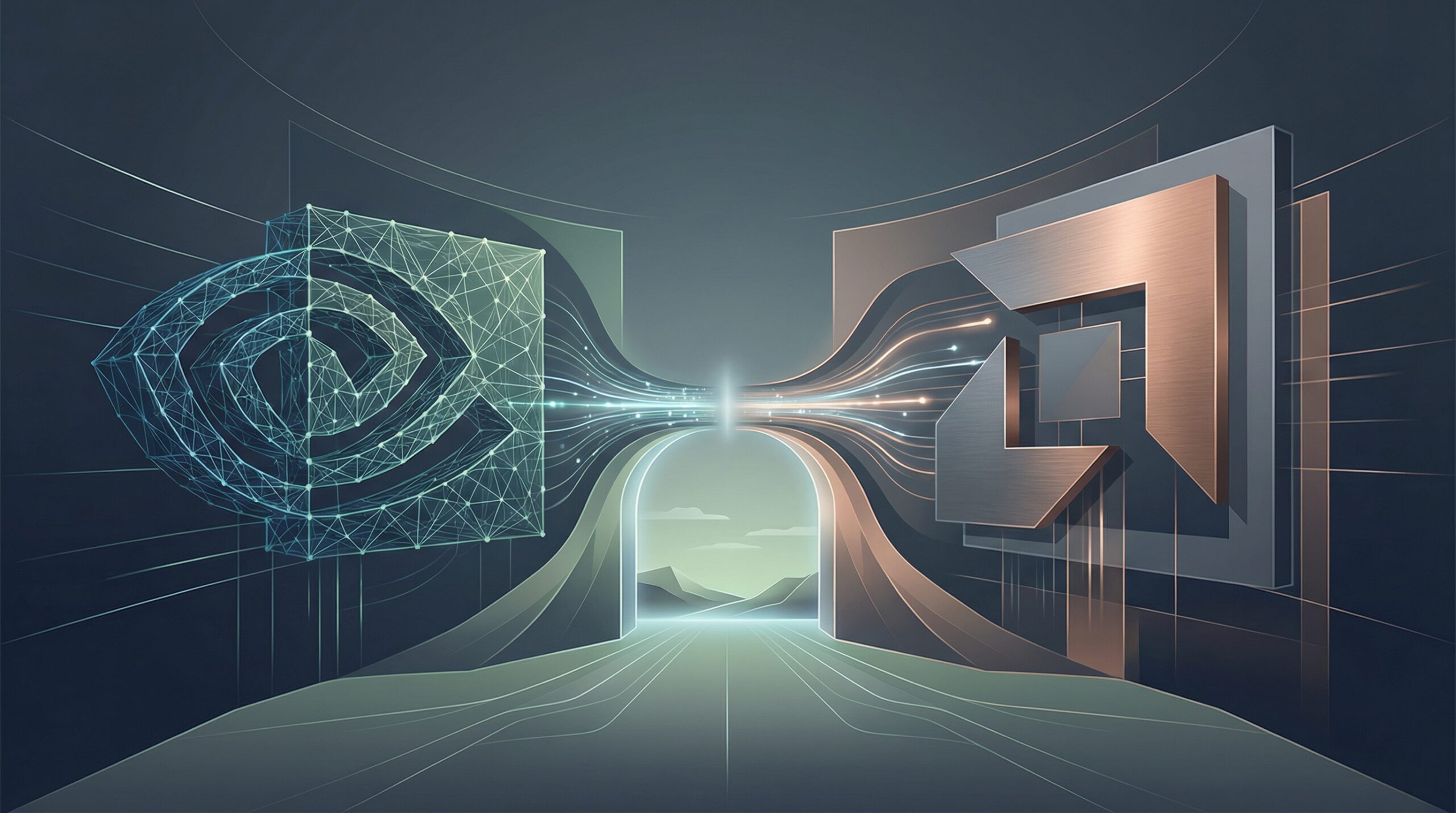

LLM(大規模言語モデル)の高速推論ライブラリとしてデファクトスタンダードの地位にある「vLLM」が、AMD製GPU環境(ROCm)へのインストールを大幅に簡素化しました。これは単なる技術的なアップデートにとどまらず、AIインフラの調達難やコスト高に悩む日本企業にとって、NVIDIA以外の選択肢が実務レベルで現実的になりつつあることを示唆しています。

「pip install」が意味するインフラの民主化

生成AIの開発・運用現場において、ハードウェアの選択肢は長らくNVIDIA一強の状態が続いてきました。その最大の理由はハードウェア性能そのものよりも、CUDAを中心とした圧倒的な「ソフトウェア・エコシステム」の成熟度にあります。しかし、最近の動向はこの勢力図に変化の兆しを見せています。

オープンソースのニュースサイトPhoronixが報じた通り、LLMの推論・サービングにおいて極めて人気の高いライブラリである「vLLM」が、AMDのGPU向けソフトウェアプラットフォームである「ROCm」に対し、Pythonの標準的なパッケージ管理ツール(pip)を通じたインストールをサポートしました。これまでAMD製GPUでvLLMを利用するには、複雑なソースコードのビルド作業が必要となるケースが多く、これが導入の大きなハードルとなっていました。今回のアップデートにより、エンジニアはNVIDIA製GPUを使うのと同様の手軽さで、AMD製GPU環境を構築できるようになります。

推論コスト削減の鍵となる「vLLM」とは

ここで改めて「vLLM」の重要性について触れておきます。vLLMは、PagedAttentionというメモリ管理技術を用いることで、LLMの推論スループット(処理能力)を飛躍的に向上させるライブラリです。MetaのLlama 3や国内発のLLMなどを本番環境で稼働させる際、遅延を抑えつつコスト効率を高めるために、vLLMは事実上の業界標準として多くの日本企業でも採用されています。

この主要なソフトウェアがAMDのプラットフォームを「ファーストクラス」としてサポートし始めたことは、実務的に大きな意味を持ちます。生成AIのランニングコストにおいて、GPUインスタンスの費用は大部分を占めます。ソフトウェアの互換性さえ確保されれば、相対的に安価で入手性の高いAMD製GPU(Instinctシリーズや民生用Radeonなど)を採用し、推論コストを最適化する道が開けるからです。

日本企業における「マルチベンダー戦略」の可能性と課題

昨今の円安や世界的なGPU争奪戦により、国内企業がH100などのNVIDIA製ハイエンドGPUを十分な数量かつ適正価格で確保することは困難を極めています。このような状況下で、AMD製GPUを選択肢に加える「マルチベンダー戦略」は、BCP(事業継続計画)や調達リスク分散の観点からも合理的です。

しかし、直ちに全面的な移行ができるかと言えば、まだ慎重な姿勢が必要です。以下のようなリスクや課題が依然として残るためです。

- エコシステムの成熟度:vLLMの対応は進みましたが、その他の周辺ツールやライブラリがすべてROCmに完全対応しているわけではありません。特定のマイナーなモデルやカスタムレイヤーを使用する場合、予期せぬエラーに遭遇する可能性があります。

- エンジニアの学習コスト:現場のエンジニアの多くはCUDA環境に慣れ親しんでいます。ROCm環境特有のトラブルシューティングには一定の学習コストが発生します。

- クラウドベンダーの対応状況:AWSやAzure、Google Cloud、あるいはさくらインターネットなどの国内クラウド事業者が、AMD製GPUインスタンスをどの程度柔軟に提供できるかも重要な要素です。

日本企業のAI活用への示唆

今回のvLLMのアップデートは、AIインフラにおける「ベンダーロックイン」からの解放に向けた重要な一歩です。日本のAI活用推進者や意思決定者は、以下の点を考慮に入れて今後のインフラ戦略を策定すべきでしょう。

- 推論基盤の分散検討:学習(Training)フェーズは依然としてNVIDIAが優位ですが、推論(Inference)フェーズにおいては、コストパフォーマンス重視でAMD製GPUを選択肢に入れる検証を開始すべき時期に来ています。

- PoCでの技術検証:いきなり本番環境へ導入するのではなく、社内向けの小規模なLLMアプリやRAG(検索拡張生成)システムの基盤として、AMD GPU + vLLMの組み合わせをテストし、安定性とコストメリットを自社で評価することを推奨します。

- 調達ポートフォリオの見直し:「AIにはNVIDIAが必要」という固定観念を捨て、利用するOSSやモデルがROCmに対応しているかを確認した上で、ハードウェア調達の多様化を図ることが、長期的なコスト競争力につながります。