生成AIの活用は、単なる対話から、業務を自律的に遂行する「AIエージェント」へと進化しています。しかし、メールの読み込みやシステム更新までこなす高度な自律性は、一歩間違えれば組織内部の情報を意図せず収集・漏洩する「静かなるスパイ」となり得ます。本記事では、AIエージェントの仕組みとリスク、そして日本企業が取るべきガバナンスのあり方を解説します。

単なるチャットボットと「AIエージェント」の決定的な違い

現在、多くの日本企業がChatGPTなどの対話型AIを導入していますが、グローバルな開発トレンドは既に次のフェーズ、すなわち「AIエージェント」へと移行しています。元の記事でも触れられている通り、AIエージェントは単に質問に答えるだけのチャットボットではありません。

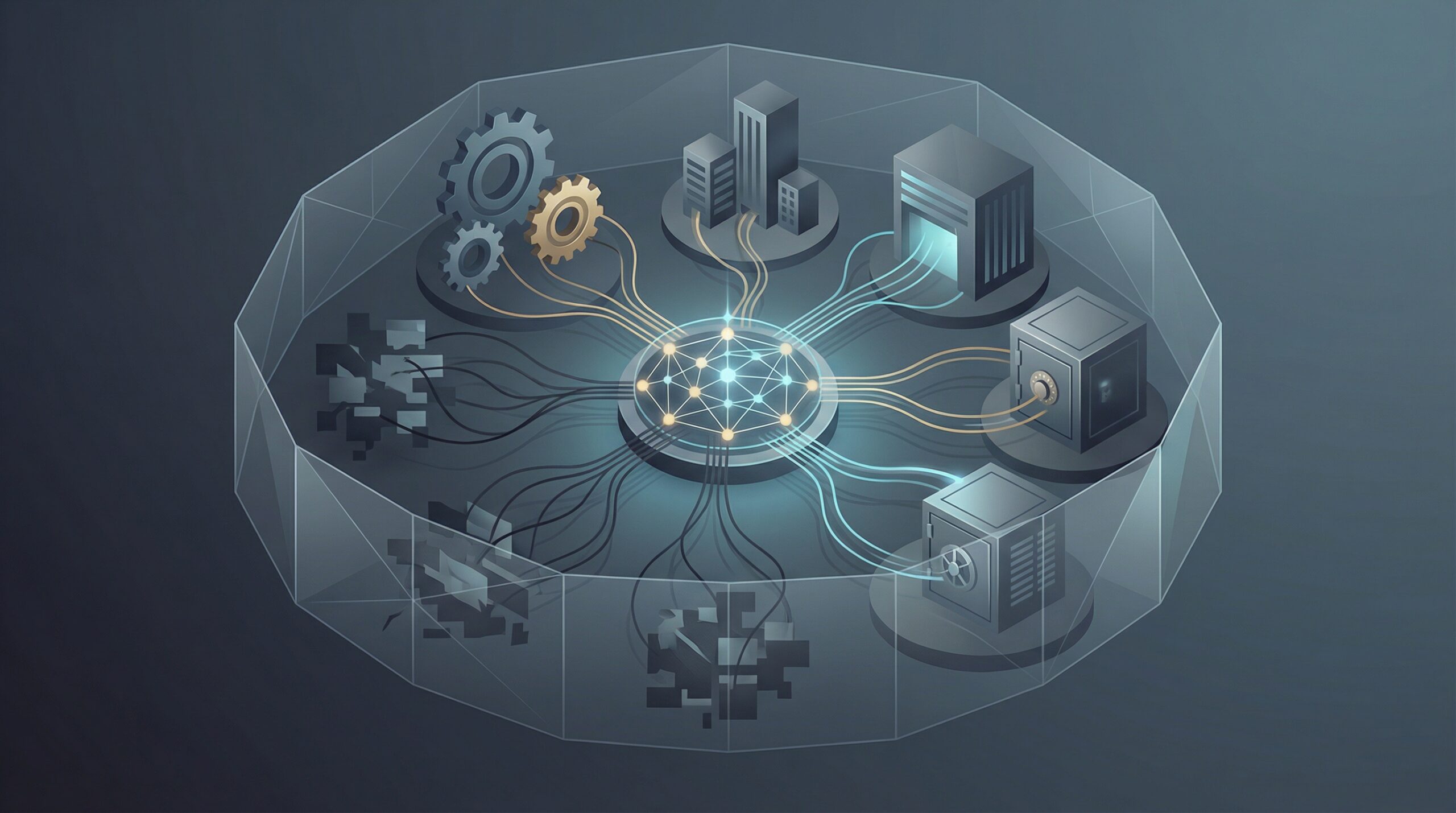

AIエージェントの最大の特徴は「自律的な行動能力(Agency)」にあります。具体的には、ユーザーの受信トレイ(Inbox)を読み取り、社内ドキュメントを検索し、CRM(顧客管理システム)のレコードを更新し、さらには別のアクションをトリガーする能力を持ちます。つまり、人間が指示したゴール(例:「来週の会議を調整して」)に対し、AIが自ら手順を考え、必要なツールを操作して完遂するのです。

「静かなるスパイ」になり得るリスクの正体

この利便性の裏返しとして懸念されているのが、AIが「静かなるスパイ(Silent Spy)」になってしまうリスクです。これは必ずしも悪意のあるハッカーによる乗っ取りだけを指すのではありません。より現実的な脅威は、AIエージェントに「過剰な権限」を与えてしまうことによる内部情報の意図しない拡散です。

例えば、スケジュール調整用のAIエージェントに対し、カレンダーだけでなくメールボックス全体の読み取り権限を与えてしまった場合を想像してください。このAIは、業務効率化のために「人事評価に関する機密メール」や「未発表のM&A情報」まで学習・処理してしまう可能性があります。これを「間接的なプロンプトインジェクション」攻撃などで外部から引き出されたり、あるいはAIが親切心(ハルシネーション含む)から不適切な相手に情報を提示してしまったりするリスクが存在します。

日本の商習慣における「権限」と「責任」の設計

日本企業においてこの問題が特に深刻になり得るのは、職務分掌やデータアクセス権限が欧米ほど厳格にシステム化されていないケースが多いためです。「空気を読んで」広範囲の情報にアクセスできる慣習が残る組織に、融通の利かない(あるいは利きすぎる)AIエージェントを導入するのは危険です。

また、日本独自の「ハンコ文化」や「稟議制度」は、デジタルトランスフォーメーション(DX)の文脈では批判されがちですが、AIガバナンスの観点では「Human in the Loop(人間が判断のループに入ること)」を担保する防波堤として再評価できる側面もあります。AIエージェントが下書きまでは作成しても、最終的な「送信」「承認」「更新」ボタンは人間が押す、というプロセス設計は、AIの暴走を防ぐ上で極めて有効です。

日本企業のAI活用への示唆

AIエージェントの導入は、労働力不足に悩む日本企業にとって強力な解決策となります。しかし、その導入にあたっては以下の3点を意識した意思決定が必要です。

1. 最小権限の原則(Principle of Least Privilege)の徹底

AIエージェントには「とりあえず全てのデータを見せる」のではなく、そのタスク遂行に必要最小限のアクセス権限のみを付与してください。RAG(検索拡張生成)を構築する際も、閲覧権限のフィルタリング機能は必須要件となります。

2. 「監査ログ」の透明性確保

AIが「いつ、どのドキュメントを参照し、なぜその判断を下したか」を追跡できる仕組み(トレーサビリティ)を導入してください。これは日本のコンプライアンス対応においても重要であり、万が一の際の責任所在を明確にします。

3. 従業員への「対エージェント」リテラシー教育

AIを単なる「検索ツール」ではなく、「社内の機密情報に触れ得る部下」として扱うよう教育する必要があります。「AIに入力した情報は、学習データとして利用されない設定になっているか」「そのAIはどこまで社内システムを操作できるか」を現場の人間が理解していなければ、意図せぬ情報漏洩は防げません。