生成AIが同じフレーズを繰り返したり、要領を得ない長い文章を出力してしまう現象は、実務導入における代表的な課題の一つです。本稿では、Frequency PenaltyやPresence Penaltyといったパラメータを活用してLLMの出力を適正化する手法と、構造的に繰り返しが多い日本語を扱う際に日本企業が留意すべきリスクと対策について解説します。

LLMが「冗長」になるメカニズム

大規模言語モデル(LLM)を活用したアプリケーション開発において、エンジニアやプロダクト担当者が頻繁に直面するのが、モデルの「ループ現象」や「冗長性」です。チャットボットが同じ説明を何度も繰り返したり、要約タスクにおいて本質的でないつなぎ言葉(フィラー)が多用されたりするケースがこれに該当します。

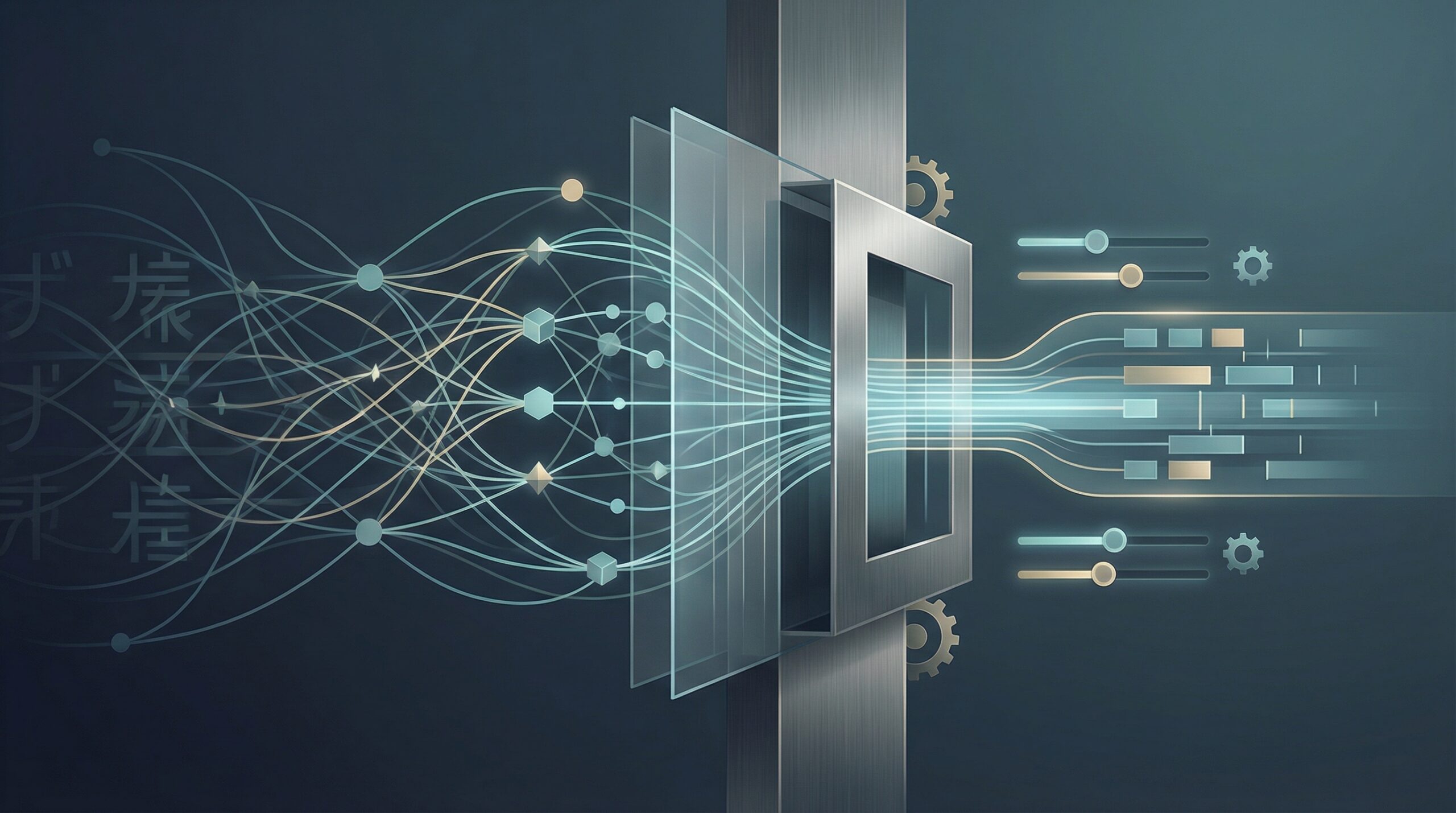

これはLLMが確率に基づいて次に出現する単語(トークン)を予測する仕組み上、特定の文脈において確率の高い単語が連続して選ばれ続け、局所的な最適解から抜け出せなくなることが原因の一つです。特に、企業独自のドキュメントを読み込ませるRAG(検索拡張生成)環境などでは、参照元の言い回しに引きずられ、不自然な反復が発生しやすくなります。

ペナルティ設定による出力制御のアプローチ

この課題に対処するための実務的なアプローチとして、主要なAPI(OpenAIやAzure OpenAI Serviceなど)で提供されている「ペナルティ設定」の調整があります。元記事でも触れられている通り、主に以下の2つのパラメータが重要になります。

- Frequency Penalty(頻度ペナルティ): テキスト内で特定のトークンが登場した「回数」に応じてペナルティを与えます。同じ単語が何度も使われるのを防ぐため、単調な繰り返しを抑制する効果があります。

- Presence Penalty(存在ペナルティ): テキスト内にそのトークンが「一度でも存在するか」に基づいてペナルティを与えます。新しいトピックへの移行を促し、同じ話題に固執することを防ぎます。

これらの値を適切に(例えば0.1〜0.5程度の範囲で微調整しながら)設定することで、モデルに対して「もっと多様な表現を使え」「同じ話を蒸し返すな」という指示を、プロンプトではなく数理的な制約として与えることが可能になります。

日本語特有の「繰り返し」と過剰制御のリスク

しかし、日本企業がこれらの設定を行う際には、日本語という言語の特性を深く理解しておく必要があります。英語と異なり、日本語は文法構造上、必然的な「繰り返し」が多く発生する言語です。

例えば、丁寧語の「〜です」「〜ます」や、助詞の「の」「に」「を」などは、一つの段落内で頻繁に出現します。もし英語の感覚でFrequency Penaltyを高く設定しすぎると、モデルは「ます」の使用を避けようとして、「〜である」「〜だ」といった常体を唐突に混ぜたり、不自然な体言止めを多用したりするなど、文章の品質(Fluency)が著しく低下するリスクがあります。

また、日本のビジネス文書では、正確性を期すためにあえて同じ用語を繰り返すことが求められる場面も少なくありません(例:「契約者」という用語を「彼/彼女」と言い換えず、常に「契約者」と記述するなど)。ペナルティ設定による過度な言い換えの強制は、こうした法的・実務的な厳密性を損なう可能性がある点に注意が必要です。

日本企業のAI活用への示唆

LLMの出力品質を安定させ、業務適用を成功させるために、以下の点を考慮すべきです。

- パラメータのローカライズ: 海外の技術記事やベストプラクティスにある数値をそのまま適用せず、日本語の文法特性に合わせてペナルティ値を低めに設定するなどの調整が必要です。

- 用途に応じた使い分け: クリエイティブなコピーライティング生成ではペナルティを効かせて表現の幅を広げ、社内マニュアルの検索応答ではペナルティを弱めて正確な用語使用を優先するなど、ユースケースごとのチューニングが求められます。

- プロンプトとの併用: パラメータだけで制御しようとせず、システムプロンプトに「簡潔に回答してください」「箇条書きを活用してください」といった指示を明確に含めることで、冗長性を排除するハイブリッドなアプローチが有効です。

- トークンコストの削減: 冗長な出力を抑制することは、API利用料(トークン課金)の削減にも直結します。品質管理だけでなく、コストガバナンスの観点からもパラメータ調整は重要な実務となります。